我使用的是Windows 10操作系统。我想在Python 3.5的Jupyter Notebook上运行Spark。我安装了一个预编译版本的Spark并设置了SPARK_HOME环境变量。我还安装了findspark并运行了以下代码:

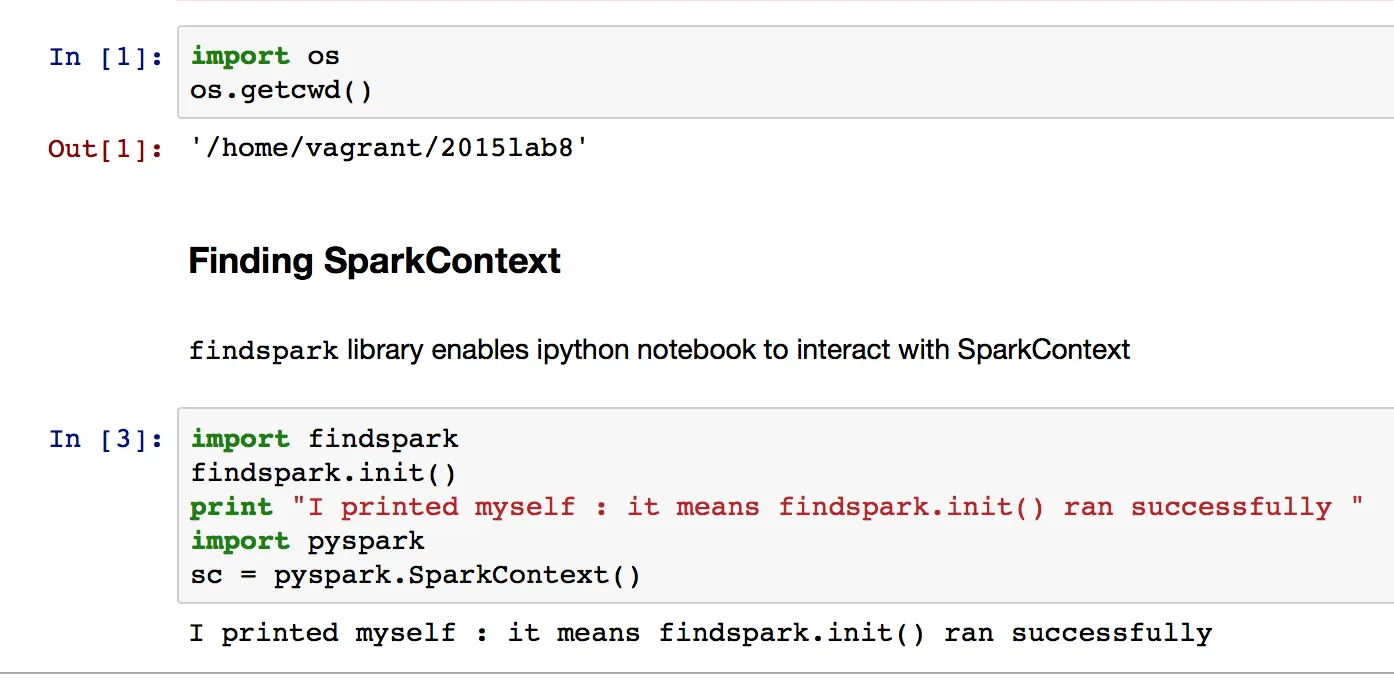

import findspark

findspark.init()

我收到了一个值错误:

ValueError: 无法找到Spark,请确保设置了SPARK_HOME环境变量或Spark位于预期位置(例如来自homebrew安装)。

但是,SPARK_HOME变量已设置。 这里 是我的系统上环境变量列表的截图。

有人遇到过这个问题或者知道如何解决吗?我只找到了一个旧的讨论,其中有人将SPARK_HOME设置为错误的文件夹,但我不认为这是我的情况。