我正在尝试将这个Scala表达式转换为Java:

val corpus: RDD[String] = sc.wholeTextFiles("docs/*.md").map(_._2)

这是我在Java中的代码:

这是我在Java中的代码:

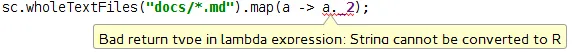

RDD<String> corpus = sc.wholeTextFiles("docs/*.md").map(a -> a._2);

但是我在a._2上遇到了一个错误:。

如果我查看“super”方法,我会看到以下内容:

package org.apache.spark.api.java.function;

import java.io.Serializable;

public interface Function<T1, R> extends Serializable {

R call(T1 var1) throws Exception;

}

a应该是类型为scala.Tuple2<String,String>。你能检查一下在你的情况下a是什么类型吗? - Luka Jacobowitzsc.wholeTextFiles("docs/*.md").<String>map(a -> a._2())- Luka Jacobowitz