我已经部署了配置为以下并行度的Flink集群:

jobmanager.heap.mb: 2048

taskmanager.heap.mb: 2048

taskmanager.numberOfTaskSlots: 5

parallelism.default: 2

但是,如果我尝试运行任何示例或jar文件,即使使用-p标志,我仍会收到以下错误:

org.apache.flink.runtime.jobmanager.scheduler.NoResourceAvailableException:

Not enough free slots available to run the job. You can decrease the operator parallelism or increase the number of slots per TaskManager in the configuration.

Task to schedule: < Attempt #1 (Source: Custom Source -> Sink: Unnamed (1/1)) @ (unassigned) - [SCHEDULED] > with groupID < 22f48c24254702e4d1674069e455c81a > in sharing group < SlotSharingGroup [22f48c24254702e4d1674069e455c81a] >. Resources available to scheduler:

Number of instances=0, total number of slots=0, available slots=0

at org.apache.flink.runtime.jobmanager.scheduler.Scheduler.scheduleTask(Scheduler.java:255)

at org.apache.flink.runtime.jobmanager.scheduler.Scheduler.scheduleImmediately(Scheduler.java:131)

at org.apache.flink.runtime.executiongraph.Execution.scheduleForExecution(Execution.java:303)

at org.apache.flink.runtime.executiongraph.ExecutionVertex.scheduleForExecution(ExecutionVertex.java:453)

at org.apache.flink.runtime.executiongraph.ExecutionJobVertex.scheduleAll(ExecutionJobVertex.java:326)

at org.apache.flink.runtime.executiongraph.ExecutionGraph.scheduleForExecution(ExecutionGraph.java:742)

at org.apache.flink.runtime.executiongraph.ExecutionGraph.restart(ExecutionGraph.java:889)

at org.apache.flink.runtime.executiongraph.restart.FixedDelayRestartStrategy$1.call(FixedDelayRestartStrategy.java:80)

at akka.dispatch.Futures$$anonfun$future$1.apply(Future.scala:94)

at scala.concurrent.impl.Future$PromiseCompletingRunnable.liftedTree1$1(Future.scala:24)

at scala.concurrent.impl.Future$PromiseCompletingRunnable.run(Future.scala:24)

at scala.concurrent.impl.ExecutionContextImpl$AdaptedForkJoinTask.exec(ExecutionContextImpl.scala:121)

at scala.concurrent.forkjoin.ForkJoinTask.doExec(ForkJoinTask.java:260)

at scala.concurrent.forkjoin.ForkJoinPool$WorkQueue.runTask(ForkJoinPool.java:1339)

at scala.concurrent.forkjoin.ForkJoinPool.runWorker(ForkJoinPool.java:1979)

at scala.concurrent.forkjoin.ForkJoinWorkerThread.run(ForkJoinWorkerThread.java:107)

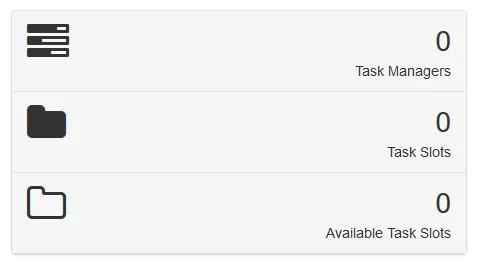

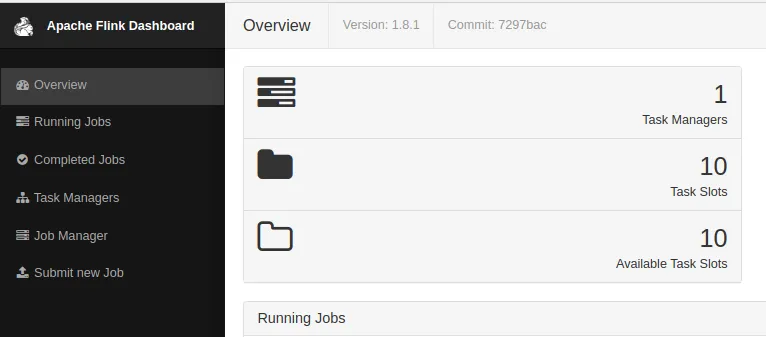

正如仪表板显示的那样,这应该不会让人感到惊讶:

我尝试了几次重新启动集群,但似乎没有使用配置。

Exception in thread "main" java.lang.UnsupportedClassVersionError: org/apache/flink/runtime/leaderretrieval/LeaderRetrievalListener : Unsupported major.minor version 51.0- Tomasz Sosiński<flink>/conf/masters和<flink>/conf/slaves文件中设置了有效的IP地址 参考链接? - Maximcurl时,它返回适当的值。看起来我有一个路由iptables的问题。感谢您的帮助,maxd! - Tomasz Sosiński