好的。我正在尝试使用不同的工具来准备开发环境,Docker是一个很好的选择。我在docker中创建了整个开发环境,并可以在其中构建项目。

该项目的源代码存储在docker容器之外(在主机上)。这样,您可以使用IDE进行编辑,并使用docker构建它。

然而,存在一个问题:

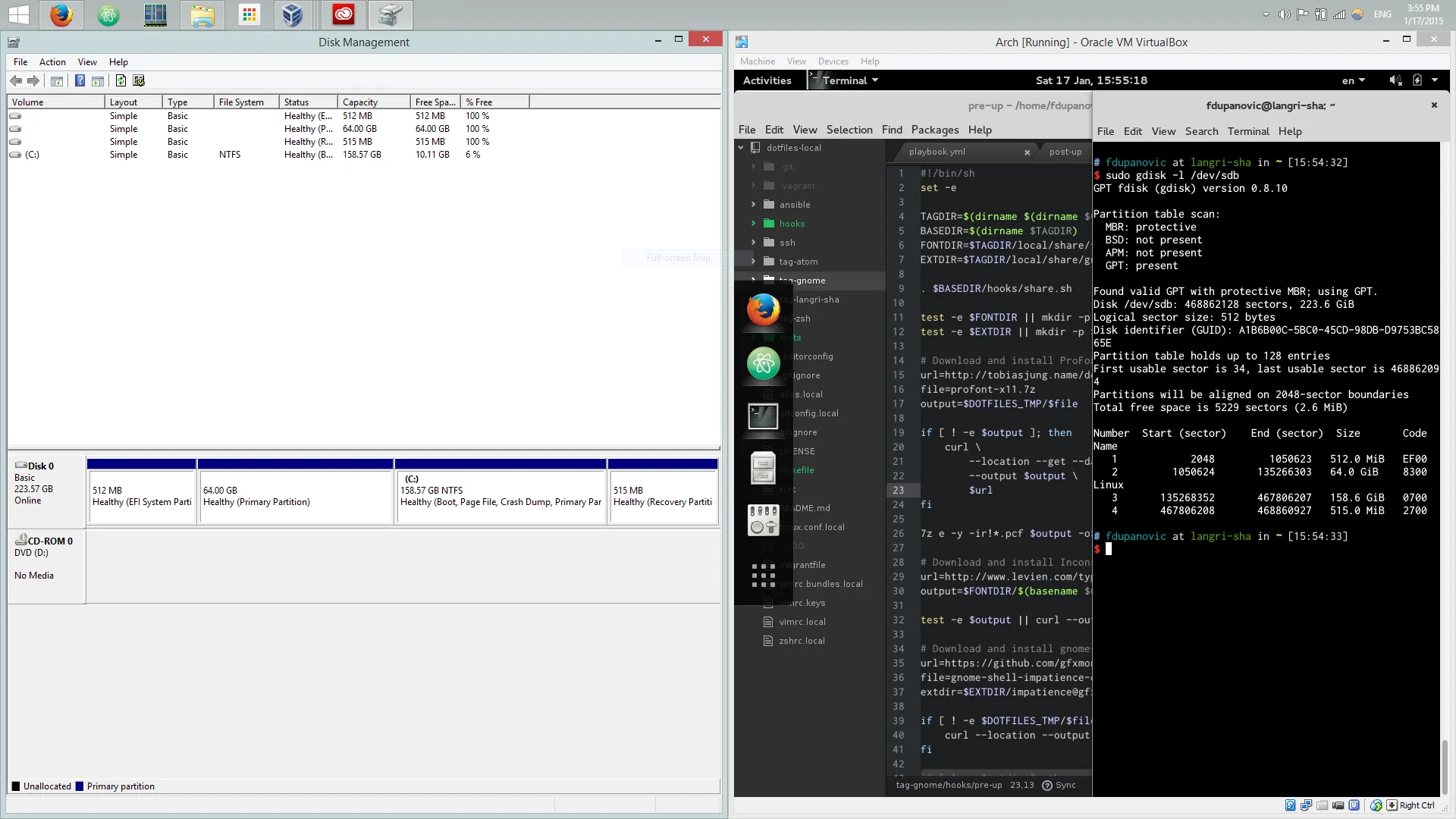

a)OS X上的Docker使用VM(VirtualBox VM)

b)文件共享速度相对较慢(比主机上的文件IO慢得多)

c)该项目有数百万个文件(夸大了问题#a和#b)。

如果我将源代码移动到docker中,IDE将面临相同的问题(它将需要访问共享文件,速度会很慢)。

我听说过一些解决方法可以加快速度。然而,我似乎找不到任何关于这个问题的信息。

更新1

我使用了Docker的文件共享功能(意味着我运行)。

docker run -P -i -v <VMDIR>:<DOCKERDIR> -t <imageName> /bin/bash

然而,虚拟机和Docker之间的共享并不是问题。它很快。

瓶颈在于主机和虚拟机之间的共享。

boot2docker现在本地支持VirtualBox扩展——至少不需要它来进行共享文件夹。 - kojiro