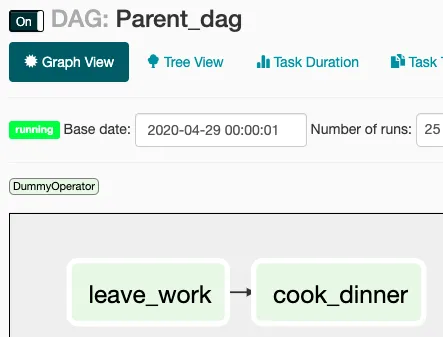

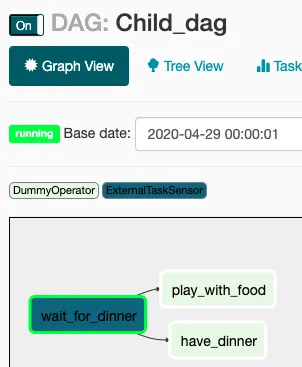

我有一个Python DAG Parent Job 和 DAG Child Job。在Parent Job每天运行成功后,应该触发Child Job中的任务。如何添加外部作业触发器?

我的代码

from datetime import datetime, timedelta

from airflow import DAG

from airflow.operators.postgres_operator import PostgresOperator

from utils import FAILURE_EMAILS

yesterday = datetime.combine(datetime.today() - timedelta(1), datetime.min.time())

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': yesterday,

'email': FAILURE_EMAILS,

'email_on_failure': False,

'email_on_retry': False,

'retries': 1,

'retry_delay': timedelta(minutes=5)

}

dag = DAG('Child Job', default_args=default_args, schedule_interval='@daily')

execute_notebook = PostgresOperator(

task_id='data_sql',

postgres_conn_id='REDSHIFT_CONN',

sql="SELECT * FROM athena_rs.shipments limit 5",

dag=dag

)

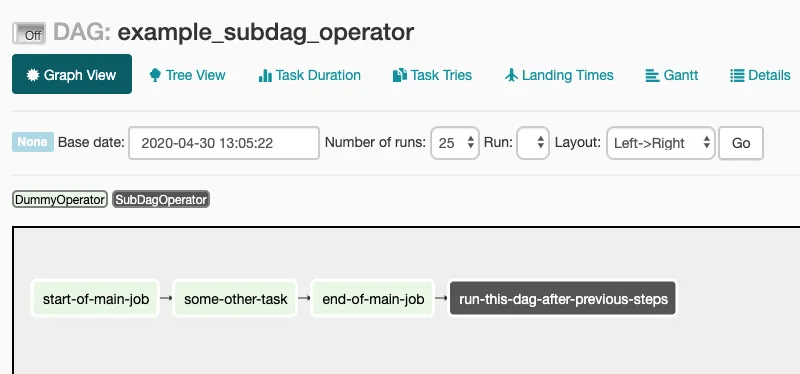

TriggerDagRunOperator来执行反应式触发,而不是使用ExternalTaskSensor来执行基于轮询的触发。 - y2k-shubhamTriggerDagRunOperator的用法。 - y2k-shubham