我相信这个问题已经在stackoverflow上有了,但是我只找到了过滤pyspark数据框中特定列为空的行的方法,而不是任何列为空的方法。

import pandas as pd

import pyspark.sql.functions as f

my_dict = {"column1":list(range(100)),"column2":["a","b","c",None]*25,"column3":["a","b","c","d",None]*20}

my_pandas_df = pd.DataFrame(my_dict)

sparkDf = spark.createDataFrame(my_pandas_df)

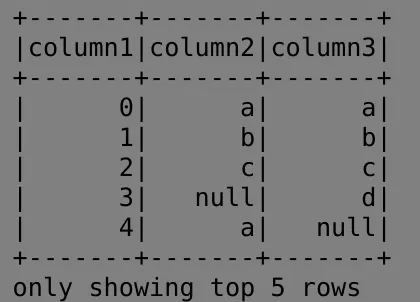

sparkDf.show(5)

我试图在DataFrame中包含任何具有空值的行,基本上是相反的操作:包含没有任何列具有空值的行:

sparkDf.na.drop()

sparkDf.na.drop(how='any').show(5)。 - anky