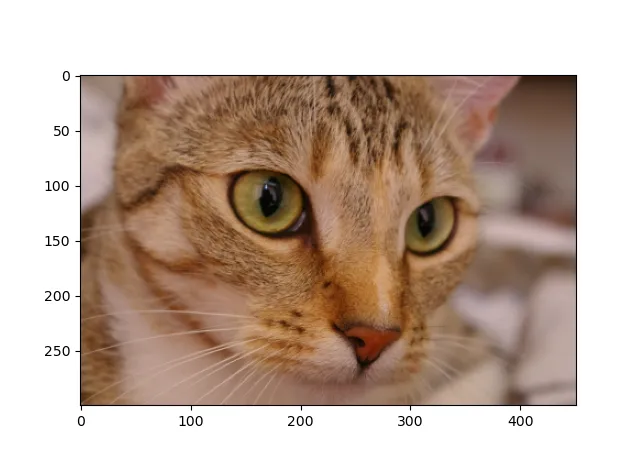

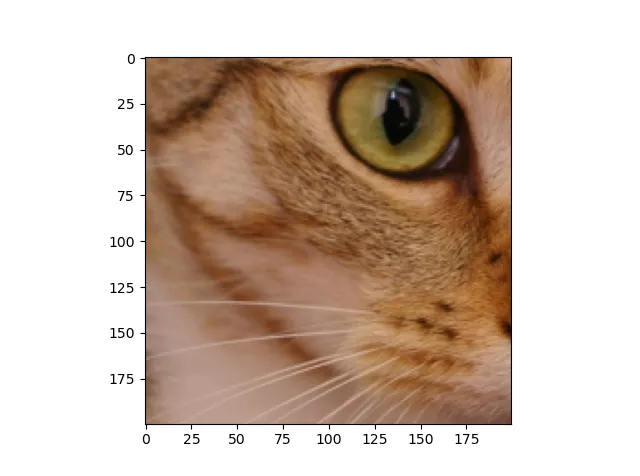

我正试图为分辨率为128x160、通道数为1的tiff文件添加随机缩放,但是Keras Tensorflow的新版本让我感到困惑,我不理解它期望的缩放范围参数应该是什么元组格式。根据文档所示。

输出为:

公共 Kaggle 笔记本在此处:

tf.keras.preprocessing.image.random_zoom(

x, zoom_range, row_axis=1, col_axis=2, channel_axis=0, fill_mode='nearest',

cval=0.0, interpolation_order=1

)

我需要给我的图像添加一些随机缩放效果,我尝试了以下方法:

zoom_range = ((0.4, 0.4))

img = tf.keras.preprocessing.image.random_zoom(

img, zoom_range, row_axis=1, col_axis=2, channel_axis=0, fill_mode='nearest',

cval=0.0, interpolation_order=1

)

输出为:

如何将任意随机缩放量作为参数传递给我的图像?类型错误:float()参数必须是字符串或数字,而不是'NoneType'

公共 Kaggle 笔记本在此处:

https://www.kaggle.com/puelon/notebook75c416766a

TypeError:用户代码中发生错误: <ipython-input-4-9ba0455797a4>:17 load *

img = tf.keras.preprocessing.image.random_zoom(img, zoom_range, row_axis=0, col_axis=1, channel_axis=2, fill_mode='nearest')

/opt/conda/lib/python3.7/site-packages/keras_preprocessing/image/affine_transformations.py:153 random_zoom *

x = apply_affine_transform(x, zx=zx, zy=zy, channel_axis=channel_axis,

/opt/conda/lib/python3.7/site-packages/keras_preprocessing/image/affine_transformations.py:321 apply_affine_transform *

transform_matrix = transform_matrix_offset_center(

/opt/conda/lib/python3.7/site-packages/keras_preprocessing/image/affine_transformations.py:246 transform_matrix_offset_center *

o_x = float(x) / 2 + 0.5

/opt/conda/lib/python3.7/site-packages/tensorflow/python/autograph/operators/py_builtins.py:195 float_ **

return _py_float(x)

/opt/conda/lib/python3.7/site-packages/tensorflow/python/autograph/operators/py_builtins.py:206 _py_float

return float(x)

TypeError: float() argument must be a string or a number, not 'NoneTyp

e'

TypeError Traceback (most recent call last)

<ipython-input-4-9ba0455797a4> in <module>

27 train1, train2, test1 = d

28 train_ds = tf.data.Dataset.from_tensor_slices(train1 + train2).\

---> 29 shuffle(len(train1) + len(train2)).map(load).batch(4)

30 test_ds = tf.data.Dataset.from_tensor_slices(test1).\

31 shuffle(len(test1)).map(load).batch(4)

for i in range(len(groups)):

d = deque(groups)

d.rotate(i)

train1, train2, test1 = d

train_ds = tf.data.Dataset.from_tensor_slices(train1 + train2).\

shuffle(len(train1) + len(train2)).map(load).batch(4)

test_ds = tf.data.Dataset.from_tensor_slices(test1).\

shuffle(len(test1)).map(load).batch(4)