1个回答

6

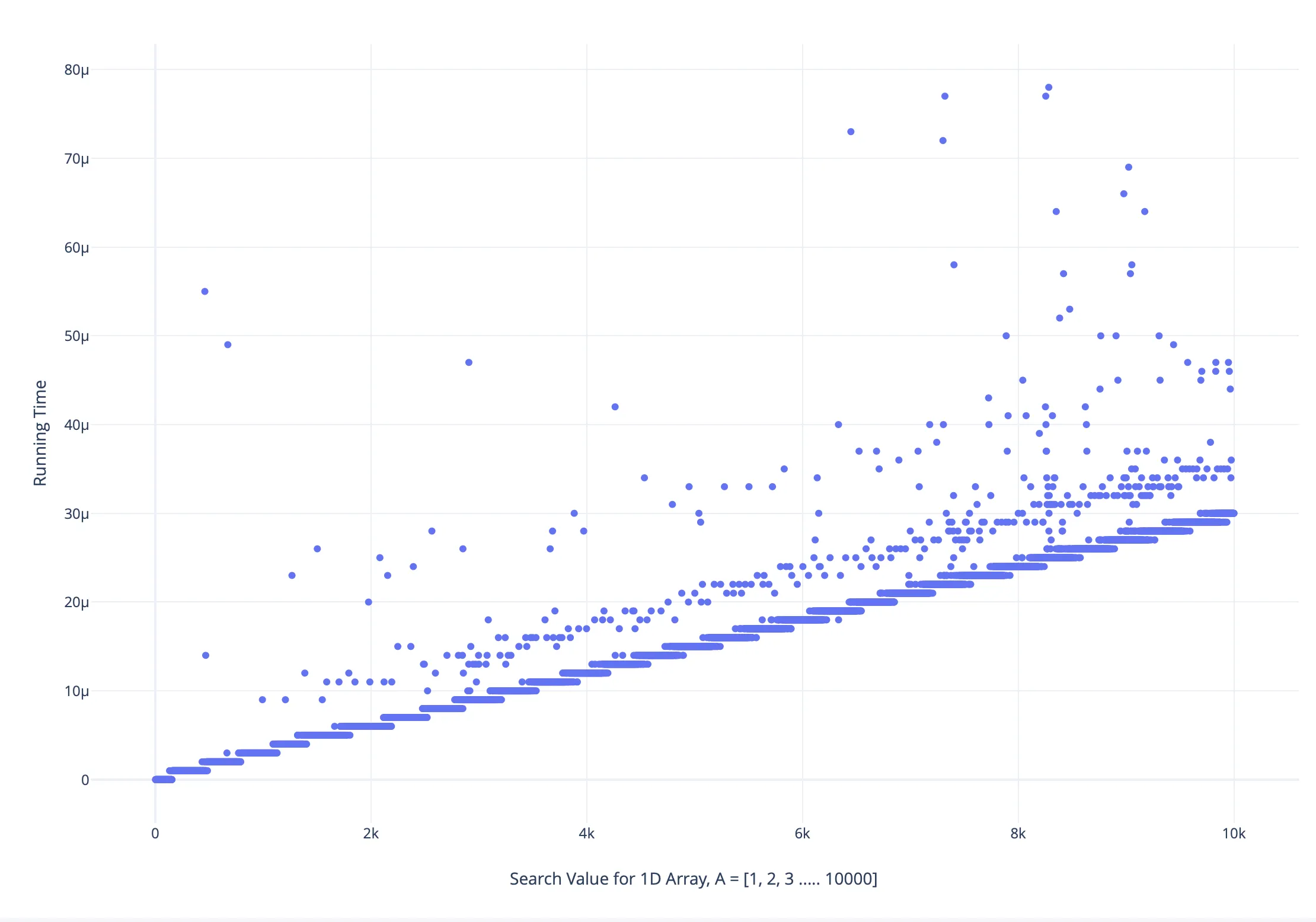

CPU缓存大小取决于CPU型号,有几个缓存级别,因此您的实验应考虑所有这些因素。L1缓存通常为8 KiB,约为10000数组的4倍小。但我认为这不是缓存未命中。L2延迟大约为100ns,比最低和第二行之间的差异(约为5微秒)要小得多。我想这(第二行云)是由上下文切换导致的。任务越长,上下文切换发生的可能性就越大。这就是为什么右侧的云更厚的原因。

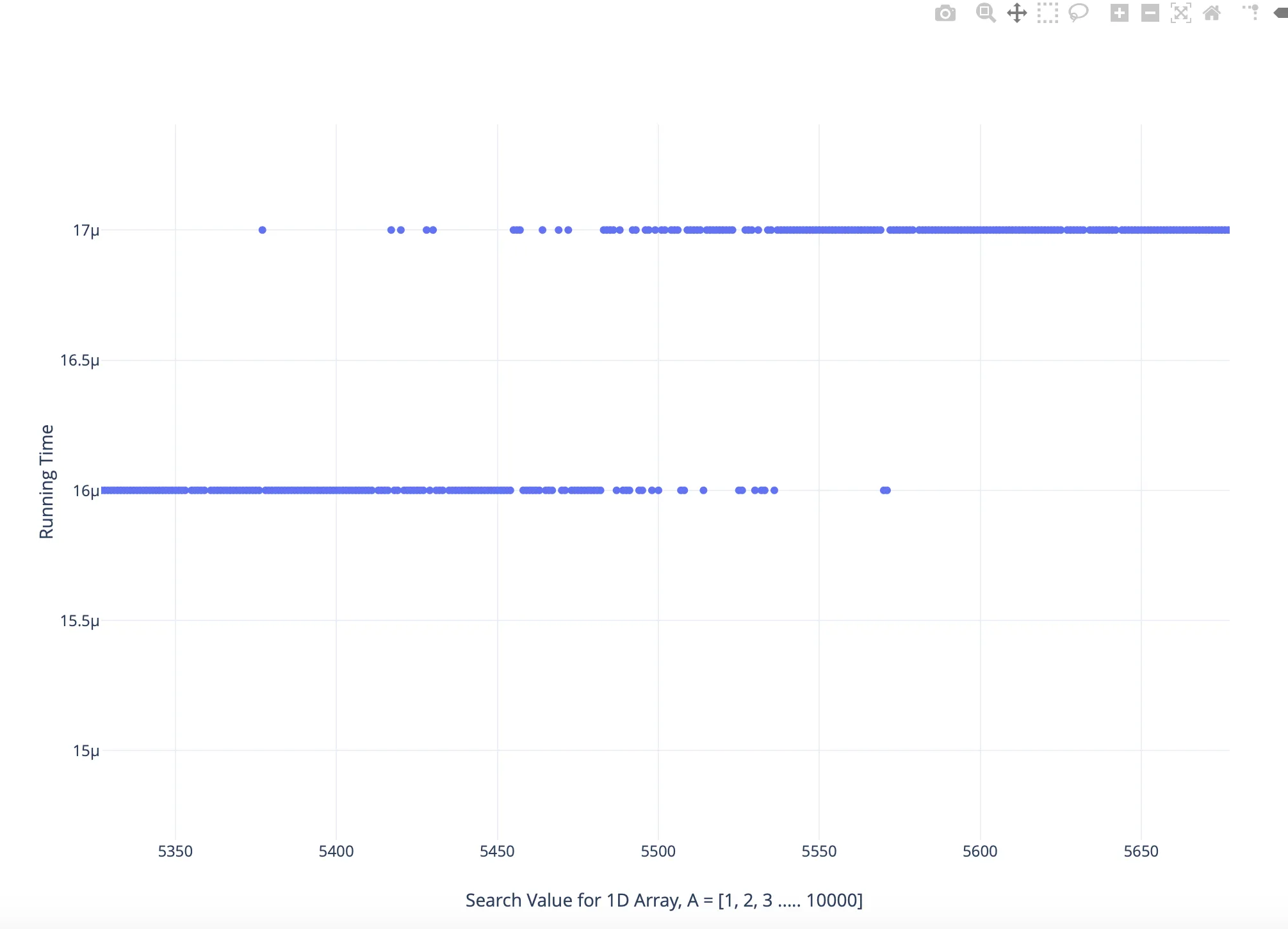

现在看放大的图。由于Linux不是实时操作系统,所以其时间测量不太可靠。我IRC它的最小报告单位是微秒。现在,如果某个任务恰好需要15.45微秒,则其结束时间取决于它何时开始。如果任务在精确的零点开始,报告的时间将是15微秒。如果它在内部时钟处于0.1微秒时开始,则会得到16微秒。您在图表上看到的是模拟直线与离散值轴的线性逼近。因此,您获得的任务持续时间不是实际任务持续时间,而是真实值加上微秒级的任务开始时间(其均匀分布约为U[0,1]),并将其舍入为最接近的整数值。

现在看放大的图。由于Linux不是实时操作系统,所以其时间测量不太可靠。我IRC它的最小报告单位是微秒。现在,如果某个任务恰好需要15.45微秒,则其结束时间取决于它何时开始。如果任务在精确的零点开始,报告的时间将是15微秒。如果它在内部时钟处于0.1微秒时开始,则会得到16微秒。您在图表上看到的是模拟直线与离散值轴的线性逼近。因此,您获得的任务持续时间不是实际任务持续时间,而是真实值加上微秒级的任务开始时间(其均匀分布约为U[0,1]),并将其舍入为最接近的整数值。

- igrinis

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接