更新:问题已解决。Docker镜像在此:docker-spark-submit

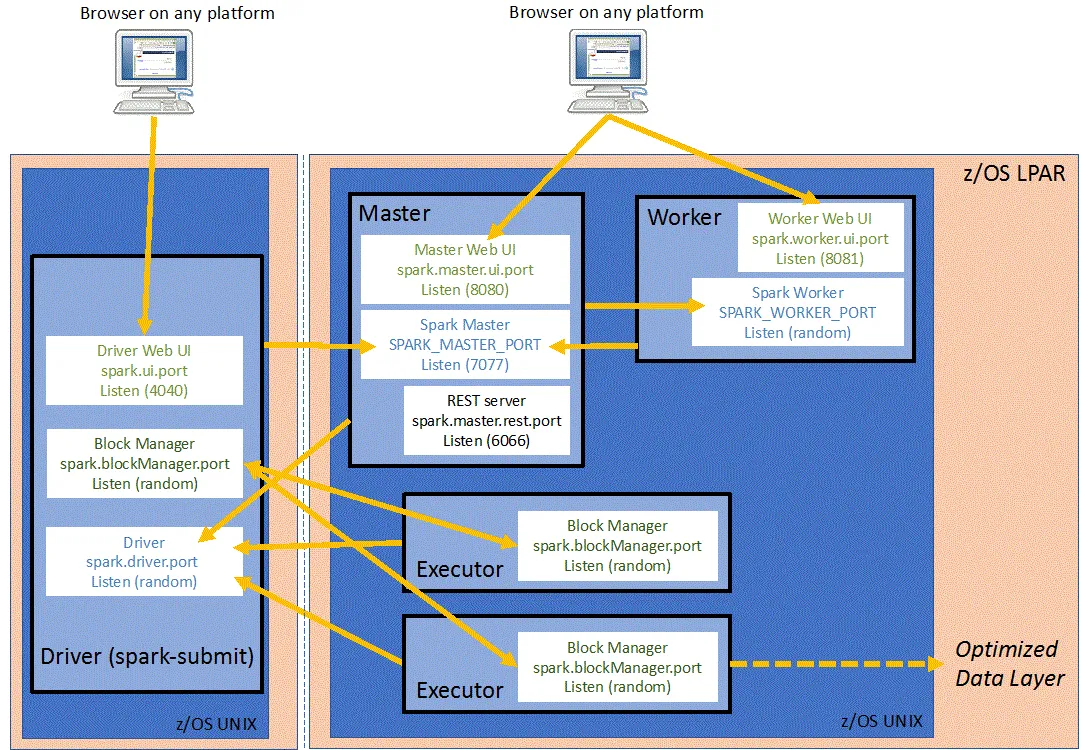

我在Docker容器中运行带有fat jar的spark-submit。我的独立Spark集群在3个虚拟机上运行,其中一个是master,另外两个是worker。从worker机器上的执行者日志中,我看到执行者具有以下驱动程序URL:

"--driver-url" "spark://CoarseGrainedScheduler@172.17.0.2:5001"

172.17.0.2实际上是驱动程序所在容器的地址,而不是容器运行的主机地址。这个IP地址无法从worker机器上访问,因此worker无法与驱动程序通信。 从StandaloneSchedulerBackend的源代码中可以看出,它使用spark.driver.host设置构建driverUrl:

val driverUrl = RpcEndpointAddress(

sc.conf.get("spark.driver.host"),

sc.conf.get("spark.driver.port").toInt,

CoarseGrainedSchedulerBackend.ENDPOINT_NAME).toString

它没有考虑到SPARK_PUBLIC_DNS环境变量 - 这是正确的吗?在容器中,我不能将spark.driver.host设置为除容器“内部”IP地址(例如本例中的172.17.0.2)以外的任何其他值。尝试将spark.driver.host设置为主机机器的IP地址时,会出现如下错误: WARN Utils:服务'sparkDriver'无法绑定到端口5001。尝试端口5002。

我尝试将spark.driver.bindAddress设置为主机机器的IP地址,但仍然遇到相同的错误。那么,如何配置Spark使用主机机器IP地址而不是Docker容器地址与驱动程序进行通信?

更新:来自执行程序的堆栈跟踪:

ERROR RpcOutboxMessage: Ask timeout before connecting successfully

Exception in thread "main" java.lang.reflect.UndeclaredThrowableException

at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1713)

at org.apache.spark.deploy.SparkHadoopUtil.runAsSparkUser(SparkHadoopUtil.scala:66)

at org.apache.spark.executor.CoarseGrainedExecutorBackend$.run(CoarseGrainedExecutorBackend.scala:188)

at org.apache.spark.executor.CoarseGrainedExecutorBackend$.main(CoarseGrainedExecutorBackend.scala:284)

at org.apache.spark.executor.CoarseGrainedExecutorBackend.main(CoarseGrainedExecutorBackend.scala)

Caused by: org.apache.spark.rpc.RpcTimeoutException: Cannot receive any reply in 120 seconds. This timeout is controlled by spark.rpc.askTimeout

at org.apache.spark.rpc.RpcTimeout.org$apache$spark$rpc$RpcTimeout$$createRpcTimeoutException(RpcTimeout.scala:48)

at org.apache.spark.rpc.RpcTimeout$$anonfun$addMessageIfTimeout$1.applyOrElse(RpcTimeout.scala:63)

at org.apache.spark.rpc.RpcTimeout$$anonfun$addMessageIfTimeout$1.applyOrElse(RpcTimeout.scala:59)

at scala.runtime.AbstractPartialFunction.apply(AbstractPartialFunction.scala:36)

at scala.util.Failure$$anonfun$recover$1.apply(Try.scala:216)

at scala.util.Try$.apply(Try.scala:192)

at scala.util.Failure.recover(Try.scala:216)

at scala.concurrent.Future$$anonfun$recover$1.apply(Future.scala:326)

at scala.concurrent.Future$$anonfun$recover$1.apply(Future.scala:326)

at scala.concurrent.impl.CallbackRunnable.run(Promise.scala:32)

at org.spark_project.guava.util.concurrent.MoreExecutors$SameThreadExecutorService.execute(MoreExecutors.java:293)

at scala.concurrent.impl.ExecutionContextImpl$$anon$1.execute(ExecutionContextImpl.scala:136)

at scala.concurrent.impl.CallbackRunnable.executeWithValue(Promise.scala:40)

at scala.concurrent.impl.Promise$DefaultPromise.tryComplete(Promise.scala:248)

at scala.concurrent.Promise$class.complete(Promise.scala:55)

at scala.concurrent.impl.Promise$DefaultPromise.complete(Promise.scala:153)

at scala.concurrent.Future$$anonfun$map$1.apply(Future.scala:237)

at scala.concurrent.Future$$anonfun$map$1.apply(Future.scala:237)

at scala.concurrent.impl.CallbackRunnable.run(Promise.scala:32)

at scala.concurrent.BatchingExecutor$Batch$$anonfun$run$1.processBatch$1(BatchingExecutor.scala:63)

at scala.concurrent.BatchingExecutor$Batch$$anonfun$run$1.apply$mcV$sp(BatchingExecutor.scala:78)

at scala.concurrent.BatchingExecutor$Batch$$anonfun$run$1.apply(BatchingExecutor.scala:55)

at scala.concurrent.BatchingExecutor$Batch$$anonfun$run$1.apply(BatchingExecutor.scala:55)

at scala.concurrent.BlockContext$.withBlockContext(BlockContext.scala:72)

at scala.concurrent.BatchingExecutor$Batch.run(BatchingExecutor.scala:54)

at scala.concurrent.Future$InternalCallbackExecutor$.unbatchedExecute(Future.scala:601)

at scala.concurrent.BatchingExecutor$class.execute(BatchingExecutor.scala:106)

at scala.concurrent.Future$InternalCallbackExecutor$.execute(Future.scala:599)

at scala.concurrent.impl.CallbackRunnable.executeWithValue(Promise.scala:40)

at scala.concurrent.impl.Promise$DefaultPromise.tryComplete(Promise.scala:248)

at scala.concurrent.Promise$class.tryFailure(Promise.scala:112)

at scala.concurrent.impl.Promise$DefaultPromise.tryFailure(Promise.scala:153)

at org.apache.spark.rpc.netty.NettyRpcEnv.org$apache$spark$rpc$netty$NettyRpcEnv$$onFailure$1(NettyRpcEnv.scala:205)

at org.apache.spark.rpc.netty.NettyRpcEnv$$anon$1.run(NettyRpcEnv.scala:239)

at java.util.concurrent.Executors$RunnableAdapter.call(Executors.java:511)

at java.util.concurrent.FutureTask.run(FutureTask.java:266)

at java.util.concurrent.ScheduledThreadPoolExecutor$ScheduledFutureTask.access$201(ScheduledThreadPoolExecutor.java:180)

at java.util.concurrent.ScheduledThreadPoolExecutor$ScheduledFutureTask.run(ScheduledThreadPoolExecutor.java:293)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1149)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:624)

at java.lang.Thread.run(Thread.java:748)

Caused by: java.util.concurrent.TimeoutException: Cannot receive any reply in 120 seconds

... 8 more