需要优化order by和count查询,我的表有数百万行数据(大约300万行)。

我必须连接4个表并获取记录,当我运行简单的查询时,它只需要毫秒就能完成,但是当我尝试使用左连接表进行计数或排序时,它会无限期地卡住。

请查看下面的情况。

数据库服务器配置:

CPU Number of virtual cores: 4

Memory(RAM): 16 GiB

Network Performance: High

每个表中的行数:

tbl_customers - #Rows: 20 million.

tbl_customers_address - #Row 25 million.

tbl_shop_setting - #Rows 50k

aio_customer_tracking - #Rows 5k

表结构:

CREATE TABLE `tbl_customers` (

`id` BIGINT(20) UNSIGNED NOT NULL AUTO_INCREMENT,

`shopify_customer_id` BIGINT(20) UNSIGNED NOT NULL,

`shop_id` BIGINT(20) UNSIGNED NOT NULL,

`email` VARCHAR(225) NULL DEFAULT NULL COLLATE 'latin1_swedish_ci',

`accepts_marketing` TINYINT(1) NULL DEFAULT NULL,

`first_name` VARCHAR(50) NULL DEFAULT NULL COLLATE 'latin1_swedish_ci',

`last_name` VARCHAR(50) NULL DEFAULT NULL COLLATE 'latin1_swedish_ci',

`last_order_id` BIGINT(20) NULL DEFAULT NULL,

`total_spent` DECIMAL(12,2) NULL DEFAULT NULL,

`phone` VARCHAR(20) NULL DEFAULT NULL COLLATE 'latin1_swedish_ci',

`verified_email` TINYINT(4) NULL DEFAULT NULL,

`updated_at` DATETIME NULL DEFAULT NULL,

`created_at` DATETIME NULL DEFAULT NULL,

`date_updated` DATETIME NULL DEFAULT NULL,

`date_created` DATETIME NULL DEFAULT NULL,

PRIMARY KEY (`id`),

UNIQUE INDEX `shopify_customer_id_unique` (`shopify_customer_id`),

INDEX `email` (`email`),

INDEX `shopify_customer_id` (`shopify_customer_id`),

INDEX `shop_id` (`shop_id`)

)

COLLATE='utf8mb4_general_ci'

ENGINE=InnoDB;

CREATE TABLE `tbl_customers_address` (

`id` BIGINT(20) NOT NULL AUTO_INCREMENT,

`customer_id` BIGINT(20) NULL DEFAULT NULL,

`shopify_address_id` BIGINT(20) NULL DEFAULT NULL,

`shopify_customer_id` BIGINT(20) NULL DEFAULT NULL,

`first_name` VARCHAR(50) NULL DEFAULT NULL,

`last_name` VARCHAR(50) NULL DEFAULT NULL,

`company` VARCHAR(50) NULL DEFAULT NULL,

`address1` VARCHAR(250) NULL DEFAULT NULL,

`address2` VARCHAR(250) NULL DEFAULT NULL,

`city` VARCHAR(50) NULL DEFAULT NULL,

`province` VARCHAR(50) NULL DEFAULT NULL,

`country` VARCHAR(50) NULL DEFAULT NULL,

`zip` VARCHAR(15) NULL DEFAULT NULL,

`phone` VARCHAR(20) NULL DEFAULT NULL,

`name` VARCHAR(50) NULL DEFAULT NULL,

`province_code` VARCHAR(5) NULL DEFAULT NULL,

`country_code` VARCHAR(5) NULL DEFAULT NULL,

`country_name` VARCHAR(50) NULL DEFAULT NULL,

`longitude` VARCHAR(250) NULL DEFAULT NULL,

`latitude` VARCHAR(250) NULL DEFAULT NULL,

`default` TINYINT(1) NULL DEFAULT NULL,

`is_geo_fetched` TINYINT(1) NOT NULL DEFAULT '0',

PRIMARY KEY (`id`),

INDEX `customer_id` (`customer_id`),

INDEX `shopify_address_id` (`shopify_address_id`),

INDEX `shopify_customer_id` (`shopify_customer_id`)

)

COLLATE='latin1_swedish_ci'

ENGINE=InnoDB;

CREATE TABLE `tbl_shop_setting` (

`id` INT(11) NOT NULL AUTO_INCREMENT,

`shop_name` VARCHAR(300) NOT NULL COLLATE 'latin1_swedish_ci',

PRIMARY KEY (`id`),

)

COLLATE='utf8mb4_general_ci'

ENGINE=InnoDB;

CREATE TABLE `aio_customer_tracking` (

`id` BIGINT(20) UNSIGNED NOT NULL AUTO_INCREMENT,

`shopify_customer_id` BIGINT(20) UNSIGNED NOT NULL,

`email` VARCHAR(255) NULL DEFAULT NULL,

`shop_id` BIGINT(20) UNSIGNED NOT NULL,

`domain` VARCHAR(255) NULL DEFAULT NULL,

`web_session_count` INT(11) NOT NULL,

`last_seen_date` DATETIME NULL DEFAULT NULL,

`last_contact_date` DATETIME NULL DEFAULT NULL,

`last_email_open` DATETIME NULL DEFAULT NULL,

`created_date` DATETIME NOT NULL,

`is_geo_fetched` TINYINT(1) NOT NULL DEFAULT '0',

PRIMARY KEY (`id`),

INDEX `shopify_customer_id` (`shopify_customer_id`),

INDEX `email` (`email`),

INDEX `shopify_customer_id_shop_id` (`shopify_customer_id`, `shop_id`),

INDEX `last_seen_date` (`last_seen_date`)

)

COLLATE='latin1_swedish_ci'

ENGINE=InnoDB;

查询正在运行和未运行的案例:

1. Running: Below query fetch the records by joining all the 4 tables, It takes only 0.300 ms.

SELECT `c`.first_name,`c`.last_name,`c`.email, `t`.`last_seen_date`, `t`.`last_contact_date`, `ssh`.`shop_name`, ca.`company`, ca.`address1`, ca.`address2`, ca.`city`, ca.`province`, ca.`country`, ca.`zip`, ca.`province_code`, ca.`country_code`

FROM `tbl_customers` AS `c`

JOIN `tbl_shop_setting` AS `ssh` ON c.shop_id = ssh.id

LEFT JOIN (SELECT shopify_customer_id, last_seen_date, last_contact_date FROM aio_customer_tracking GROUP BY shopify_customer_id) as t ON t.shopify_customer_id = c.shopify_customer_id

LEFT JOIN `tbl_customers_address` as ca ON (c.shopify_customer_id = ca.shopify_customer_id AND ca.default = 1)

GROUP BY c.shopify_customer_id

LIMIT 20

2. Not running: Simply when try to get the count of these row stuk the query, I waited 10 min but still running.

SELECT

COUNT(DISTINCT c.shopify_customer_id) -- what makes #2 different

FROM `tbl_customers` AS `c`

JOIN `tbl_shop_setting` AS `ssh` ON c.shop_id = ssh.id

LEFT JOIN (SELECT shopify_customer_id, last_seen_date, last_contact_date FROM aio_customer_tracking GROUP BY shopify_customer_id) as t ON t.shopify_customer_id = c.shopify_customer_id

LEFT JOIN `tbl_customers_address` as ca ON (c.shopify_customer_id = ca.shopify_customer_id AND ca.default = 1)

GROUP BY c.shopify_customer_id

LIMIT 20

3. Not running: In the #1 query we simply put the 1 Order by clause and it get stuck, I waited 10 min but still running. I study query optimization some article and tried by indexing, Right Join etc.. but still not working.

SELECT `c`.first_name,`c`.last_name,`c`.email, `t`.`last_seen_date`, `t`.`last_contact_date`, `ssh`.`shop_name`, ca.`company`, ca.`address1`, ca.`address2`, ca.`city`, ca.`province`, ca.`country`, ca.`zip`, ca.`province_code`, ca.`country_code`

FROM `tbl_customers` AS `c`

JOIN `tbl_shop_setting` AS `ssh` ON c.shop_id = ssh.id

LEFT JOIN (SELECT shopify_customer_id, last_seen_date, last_contact_date FROM aio_customer_tracking GROUP BY shopify_customer_id) as t ON t.shopify_customer_id = c.shopify_customer_id

LEFT JOIN `tbl_customers_address` as ca ON (c.shopify_customer_id = ca.shopify_customer_id AND ca.default = 1)

GROUP BY c.shopify_customer_id

ORDER BY `t`.`last_seen_date` -- what makes #3 different

LIMIT 20

欢迎提出优化查询和表结构的建议。

我的目标:

tbl_customers 表包含客户信息,tbl_customer_address 表包含客户地址(一个客户可能有多个地址),aio_customer_tracking 表包含客户访问记录,其中 last_seen_date 是最近的访问日期。

现在,我想获取并计算客户数量、其中一个地址以及访问信息。同时,我可以根据这三个表中的任何列进行排序。在我的例子中,我按照最近访问日期(默认排序)进行排序。希望这个解释能够帮助您理解我要做什么。

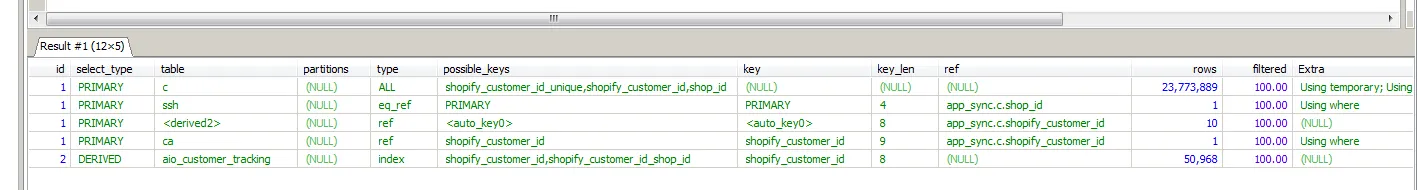

select last_seen_date from table group by id会随机返回一个last_seen_date行(请参见例如这里),然后您想要按此排序。在您的第二个查询中,count(distinct x) group by x是多余的(它始终为1,这就是group by的目的),同时您使用left join连接到它也没有效果(但是再次强调,您可能想要查询不同的内容)。 - Solarflarelast_seen_date排序将首先列出null;2000万客户和(最多)5k个具有last_seen_date的客户将使您获得19,995,000行,其中null排在第一位(因此为了优化,只需删除order by)。如果您想获取具有实际last_seen_date的行,则查询可能会在不到一秒钟内完成(删除left join可能已经可以),但是再次强调,我们并不真正知道您的期望结果是什么,因此在尝试优化之前,请尝试让其正常工作/给出正确的结果。(如果您添加详细信息/示例数据/期望结果,我们可以帮助您解决问题)。 - SolarflareEXPLAIN SELECT ...。 - Rick James