我是TensorFlow框架的新手,正在尝试使用TensorFlow来预测基于Titanic数据集的幸存者:https://www.kaggle.com/c/titanic/data。

import tensorflow as tf

import numpy as np

import pandas as pd

from sklearn.model_selection import train_test_split

#%%

titanictrain = pd.read_csv('train.csv')

titanictest = pd.read_csv('test.csv')

df = pd.concat([titanictrain,titanictest],join='outer',keys='PassengerId',sort=False,ignore_index=True).drop(['Name'],1)

#%%

def preprocess(df):

df['Fare'].fillna(value=df.groupby('Pclass')['Fare'].transform('median'),inplace=True)

df['Fare'] = df['Fare'].map(lambda x: np.log(x) if x>0 else 0)

df['Embarked'].fillna(value=df['Embarked'].mode()[0],inplace=True)

df['CabinAlphabet'] = df['Cabin'].str[0]

categories_to_one_hot = ['Pclass','Sex','Embarked','CabinAlphabet']

df = pd.get_dummies(df,columns=categories_to_one_hot,drop_first=True)

return df

df = preprocess(df)

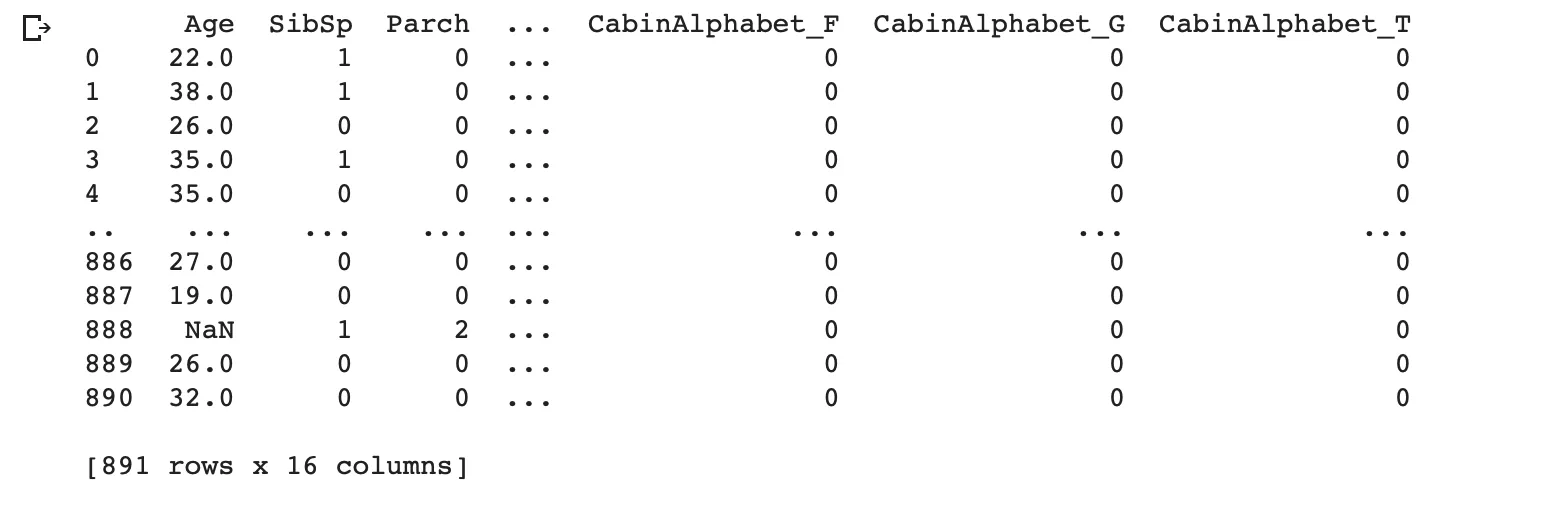

df = df.drop(['PassengerId','Ticket','Cabin','Survived'],1)

titanic_trainandval = df.iloc[:len(titanictrain)]

titanic_test = df.iloc[len(titanictrain):] #test after preprocessing

titanic_test.head()

# split train into training and validation set

labels = titanictrain['Survived']

y = labels.values

test = titanic_test.copy() # real test sets

print(len(test), 'test examples')

这里我正在尝试对数据进行预处理:

1.删除名称列并在训练集和测试集上进行独热编码

2.为了简单起见,删除 ['PassengerId','Ticket','Cabin','Survived']。

- 按原始顺序拆分训练集和测试集

"""# model training"""

from tensorflow.keras.layers import Input, Dense, Activation,Dropout

from tensorflow.keras.models import Model

X = titanic_trainandval.copy()

input_layer = Input(shape=(X.shape[1],))

dense_layer_1 = Dense(10, activation='relu')(input_layer)

dense_layer_2 = Dense(5, activation='relu')(dense_layer_1)

output = Dense(1, activation='softmax',name = 'predictions')(dense_layer_2)

model = Model(inputs=input_layer, outputs=output)

base_learning_rate = 0.0001

model.compile(loss=tf.keras.losses.BinaryCrossentropy(from_logits=True), optimizer=tf.keras.optimizers.Adam(lr=base_learning_rate), metrics=['acc'])

history = model.fit(X, y, batch_size=5, epochs=20, verbose=2, validation_split=0.1,shuffle = False)

submission = pd.DataFrame()

submission['PassengerId'] = titanictest['PassengerId']

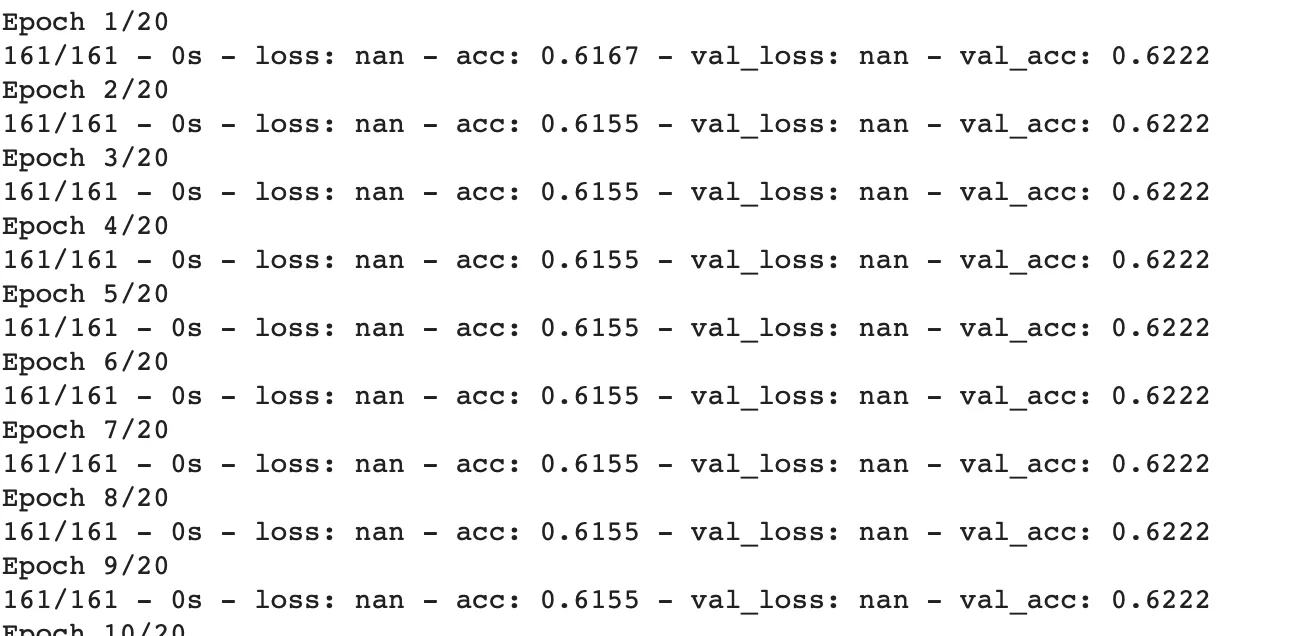

然后我将训练集X放入模型中得到结果。然而,历史记录显示以下结果:

无论我如何改变学习率和批量大小,结果都不会改变,损失始终为“nan”,基于测试集的预测也始终为“nan”。

有人能解释一下问题出在哪里并提供一些可能的解决方案吗?