我的spark.cores.max设置为24[3个工作节点],但是如果我进入我的工作节点并查看只有一个进程[命令=Java]正在运行,消耗内存和CPU。 我怀疑它没有使用所有的8个核心(在m2.4x large上)。

如何知道这个数字?

我的spark.cores.max设置为24[3个工作节点],但是如果我进入我的工作节点并查看只有一个进程[命令=Java]正在运行,消耗内存和CPU。 我怀疑它没有使用所有的8个核心(在m2.4x large上)。

如何知道这个数字?

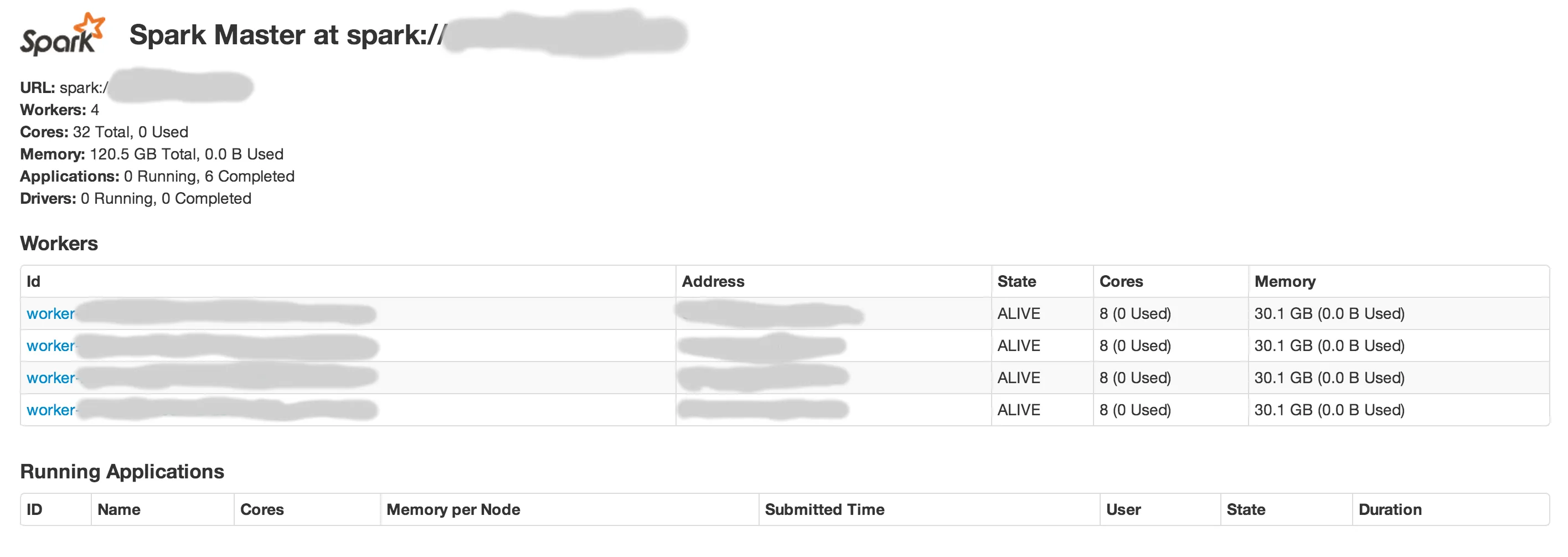

您可以在Spark Web UI下看到集群中每个worker占用的核心数量: