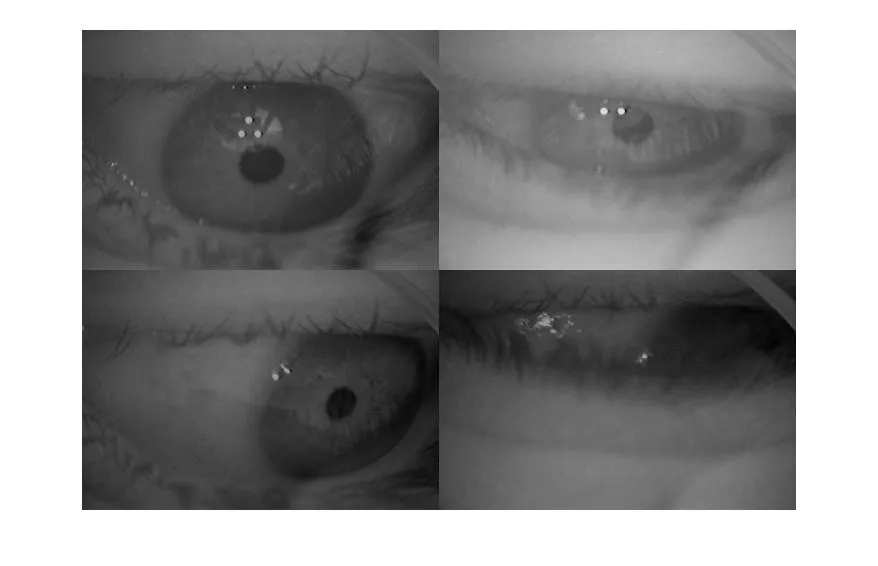

我正在寻求有关如何解决以下计算机视觉问题的建议。下面是我正在处理的一个眼动数据集的4个样本。我想编写代码,以获取这样的图像并计算瞳孔中心的(x, y)位置。我目前正在使用MATLAB,但我也可以使用其他软件。

是否有人可以推荐一种方法来解决这个任务?以下是我已经尝试过但效果不太好的一些方法。

- 我尝试使用圆形霍夫变换,但这需要我猜测瞳孔的半径,这有点棘手。此外,由于畸变,瞳孔不总是完全圆形的,这可能会使这种方法更加困难。

- 我尝试根据像素亮度阈值化图像,并使用regionprops MATLAB函数查找大约200像素区域内非常低的偏心率(即尽可能圆形)。然而,这对阈值值非常敏感,并且基于光照条件,一些眼睛的图像比其他眼睛的图像亮。 (请注意,下面的4个样本已经进行了平均归一化,但仍有一个图像比其他图像亮,可能是因为某个非常黑暗的随机像素)

欢迎任何评论/建议!

编辑:感谢Stargazer的评论。理想情况下,算法应该能够确定瞳孔不在图像中,就像最后一个样本一样。如果我暂时跟丢它,这并不是什么大问题。但是如果它给我错误的答案,则情况要严重得多。