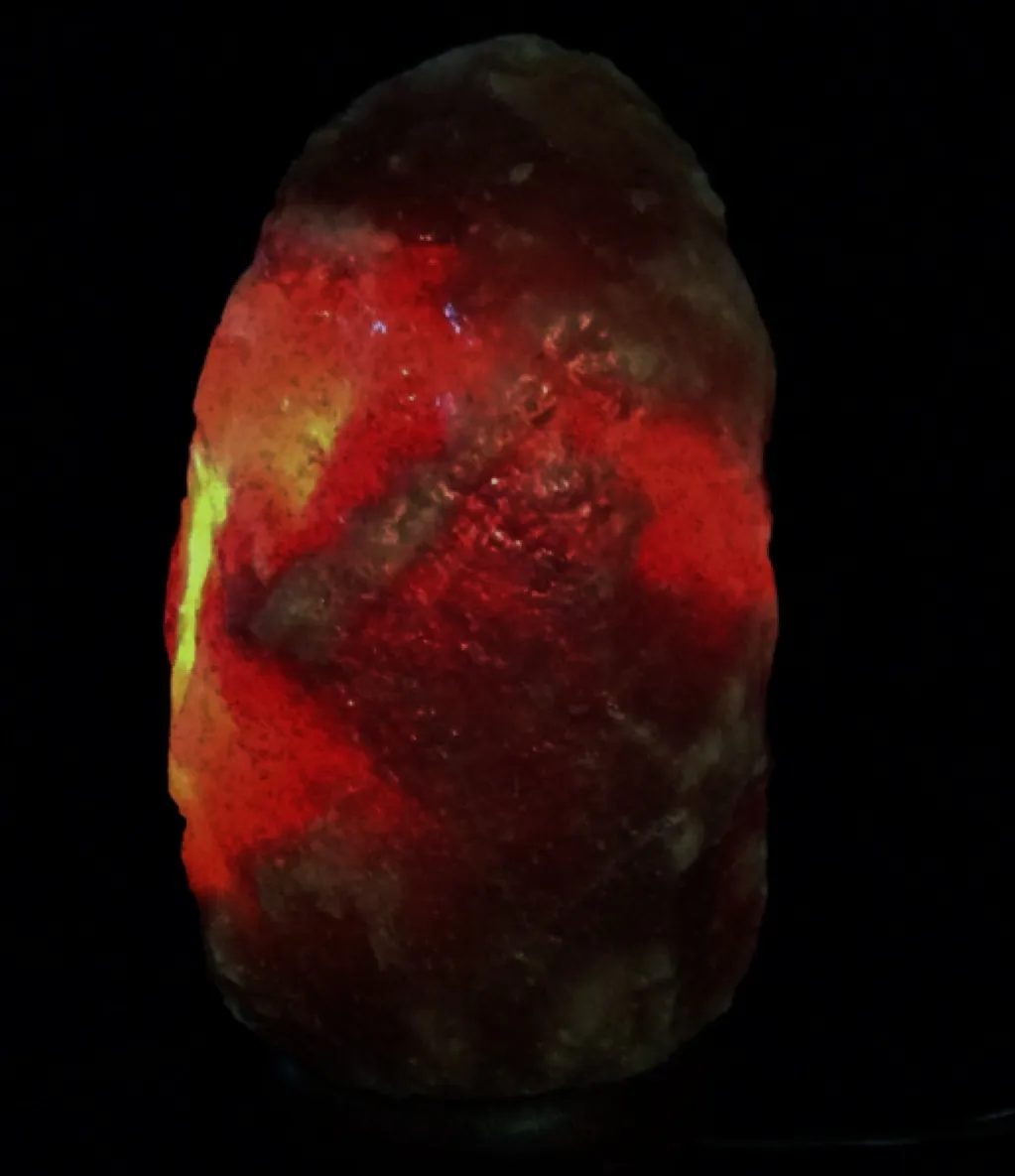

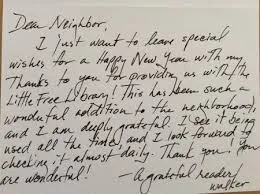

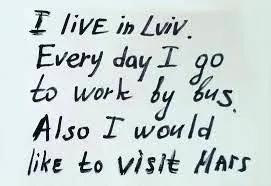

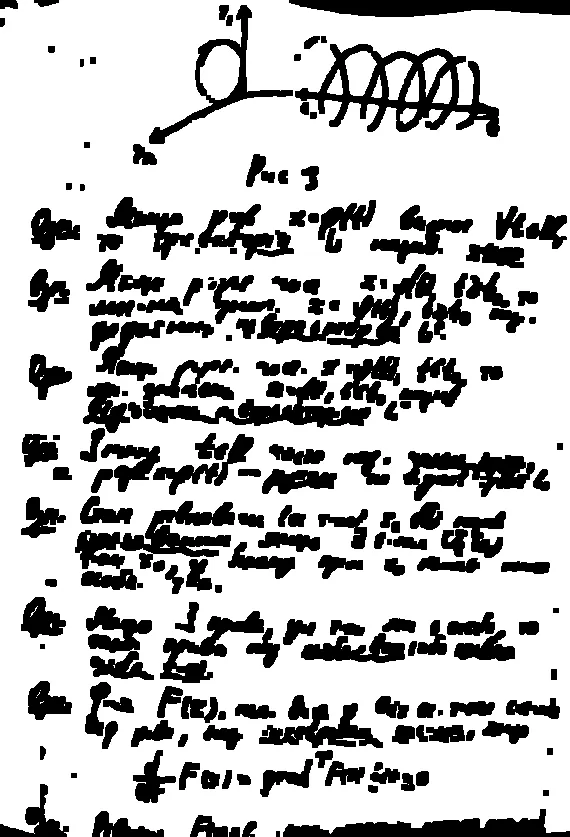

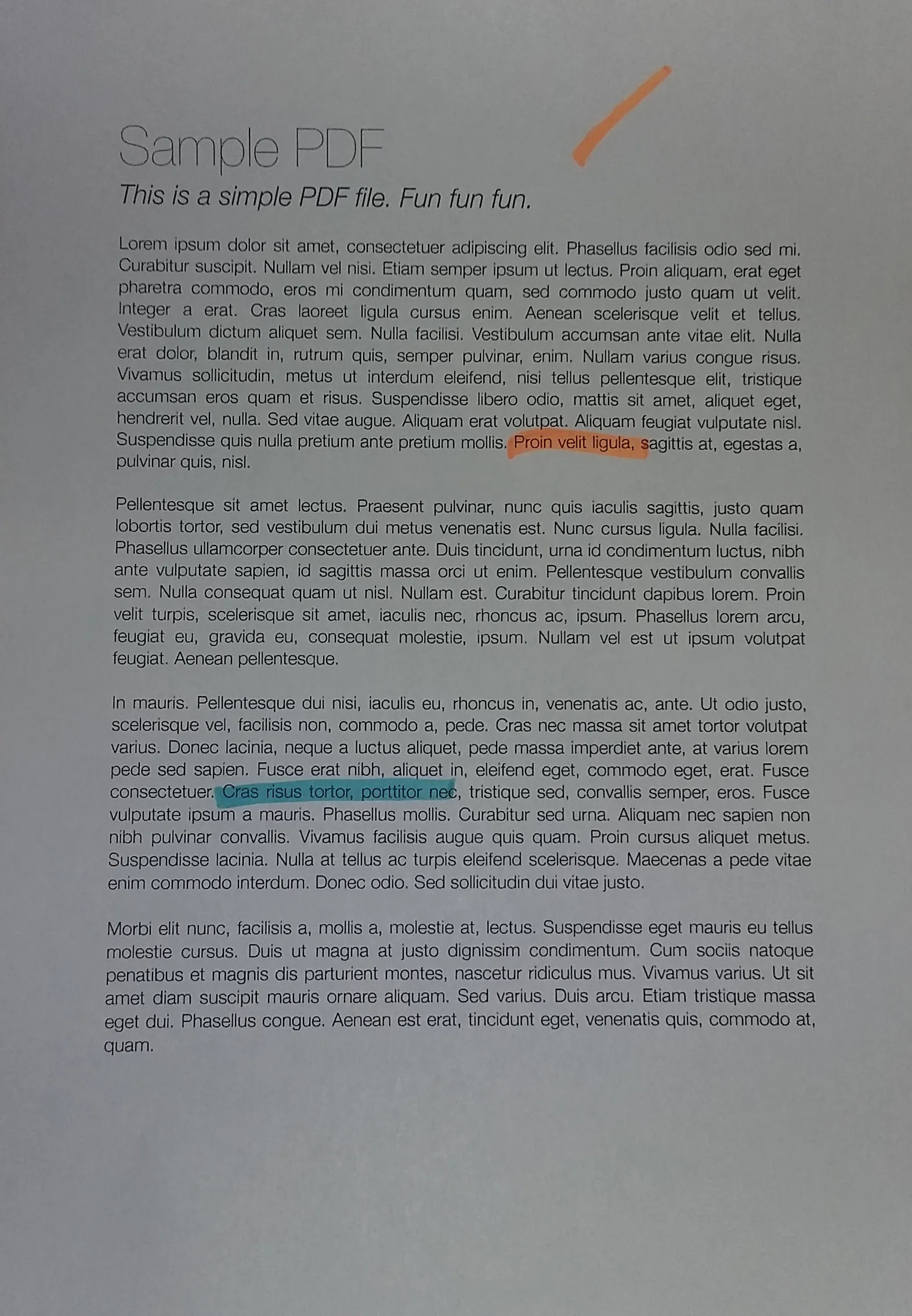

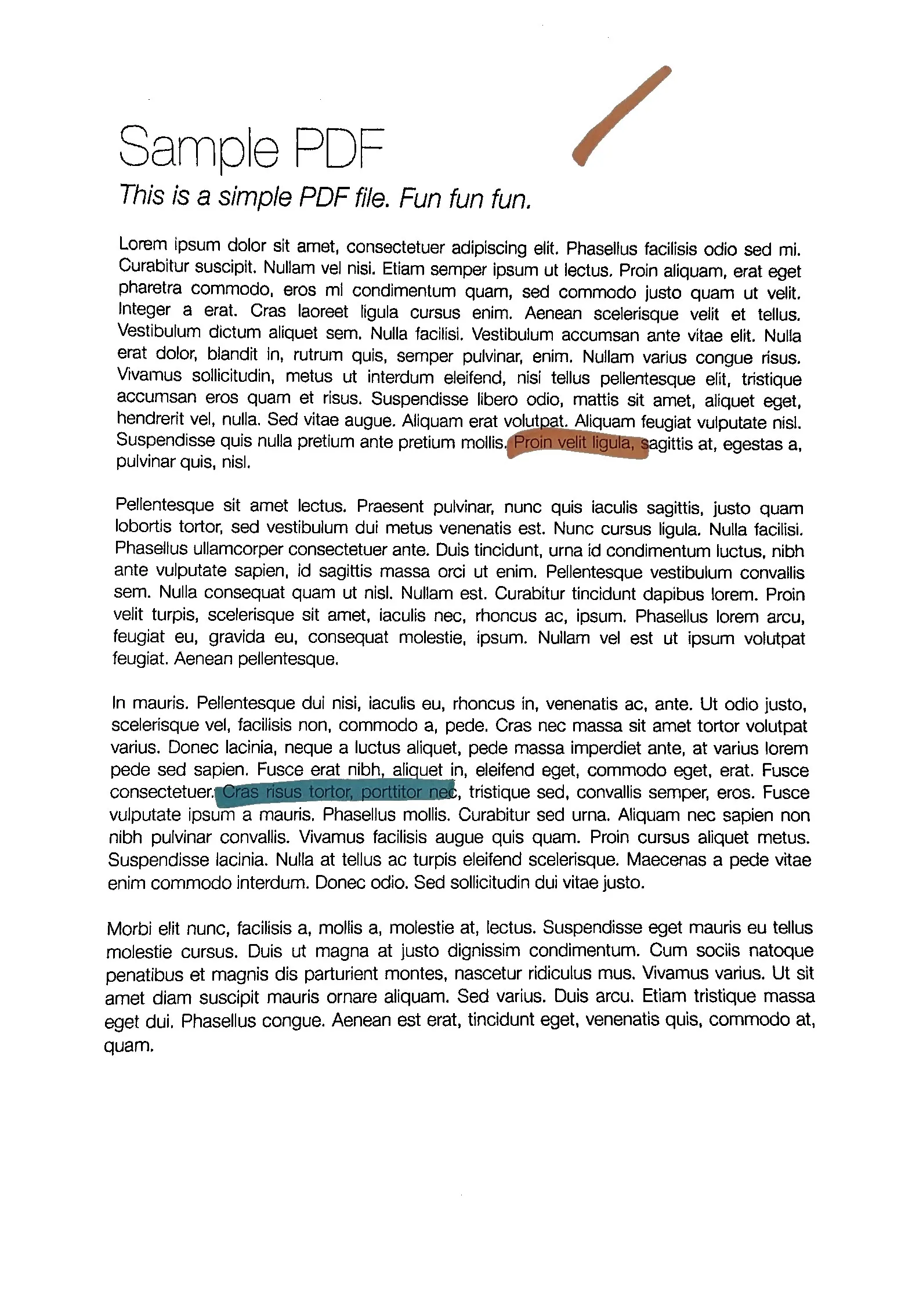

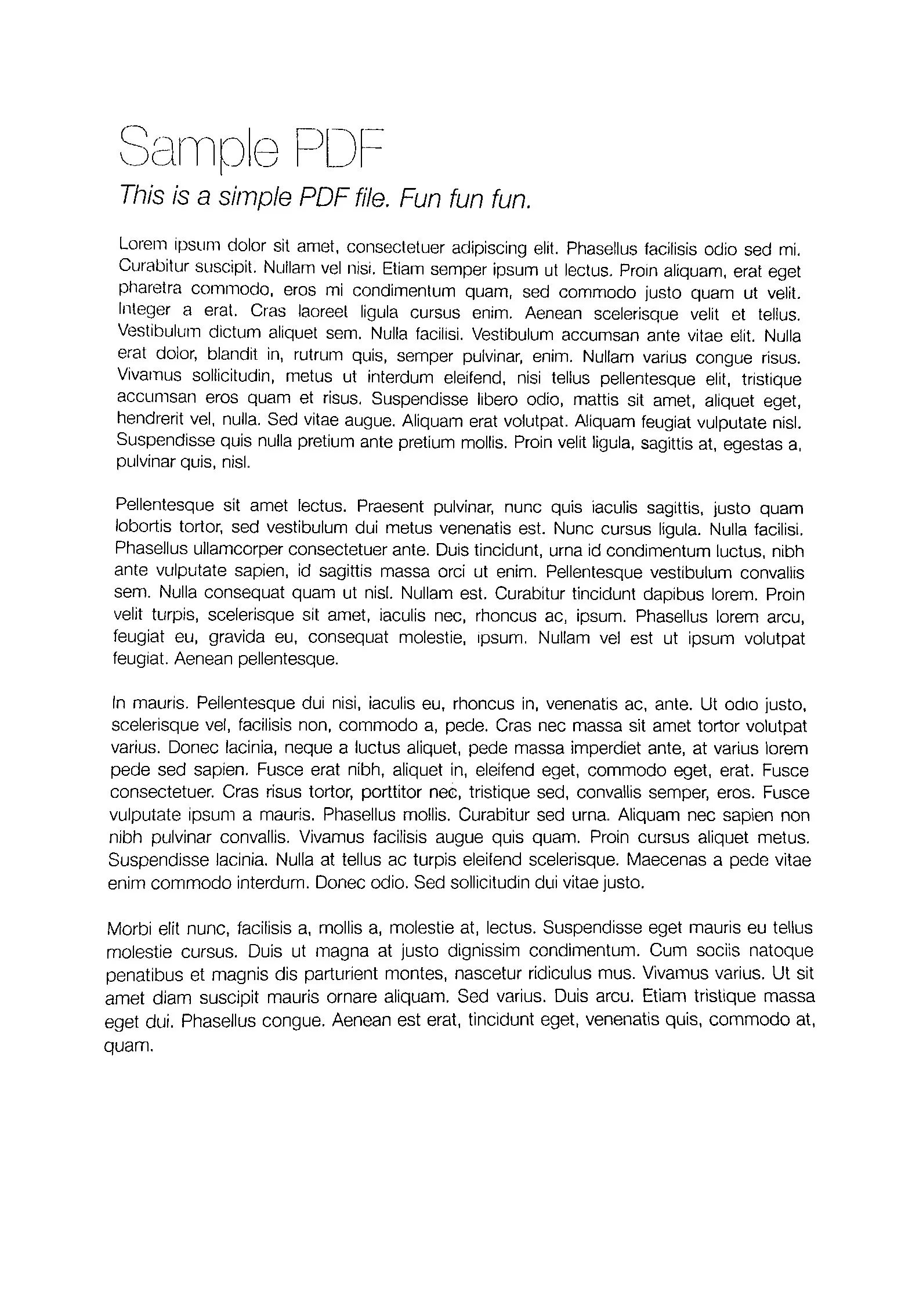

当拍摄一张纸(例如使用手机相机)时,我得到了以下结果(左图)(jpg下载此处)。期望的结果(使用图像编辑软件手动处理)在右侧:

假设:图像具有A4纵向格式(我们不需要在此主题中进行透视变换),纸张是白色的,可能有黑色或彩色的文本/图像。

我尝试过的方法:

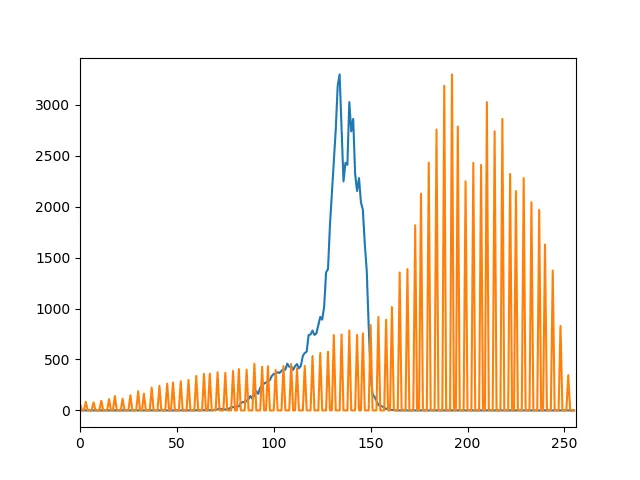

Various adaptive thresholding methods such as Gaussian, OTSU (see OpenCV doc Image Thresholding). It usually works well with OTSU:

ret, gray = cv2.threshold(img, 0, 255, cv2.THRESH_OTSU + cv2.THRESH_BINARY)but it only works for grayscale images and not directly for color images. Moreover, the output is binary (white or black), which I don't want: I prefer to keep a color non-binary image as output

-

- applied on Y (after RGB => YUV transform)

- or applied on V (after RGB => HSV transform),

as suggested by this answer (Histogram equalization not working on color image - OpenCV) or this one (OpenCV Python equalizeHist colored image):

img3 = cv2.imread(f) img_transf = cv2.cvtColor(img3, cv2.COLOR_BGR2YUV) img_transf[:,:,0] = cv2.equalizeHist(img_transf[:,:,0]) img4 = cv2.cvtColor(img_transf, cv2.COLOR_YUV2BGR) cv2.imwrite('test.jpg', img4)or with HSV:

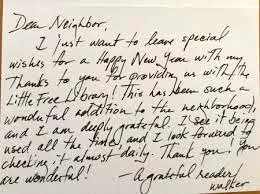

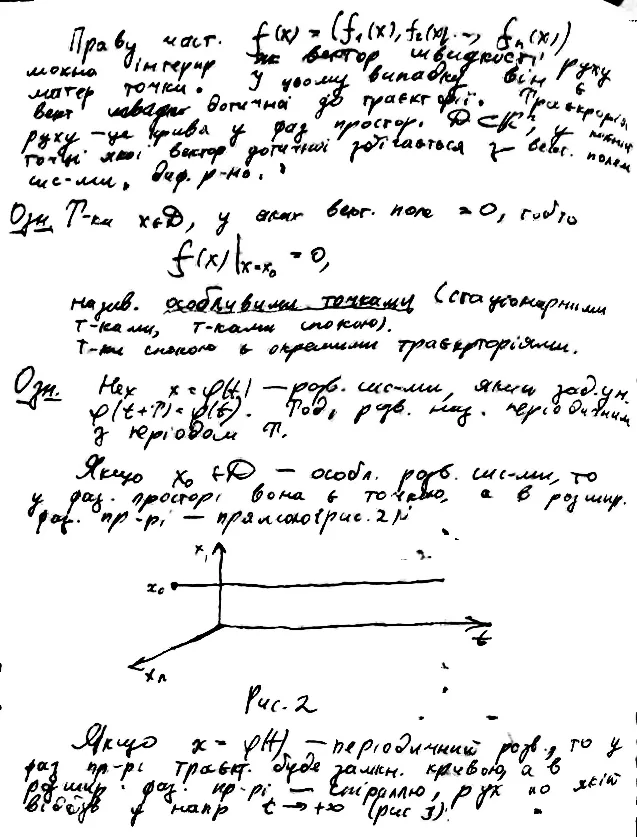

img_transf = cv2.cvtColor(img3, cv2.COLOR_BGR2HSV) img_transf[:,:,2] = cv2.equalizeHist(img_transf[:,:,2]) img4 = cv2.cvtColor(img_transf, cv2.COLOR_HSV2BGR)Unfortunately, the result is quite bad since it creates awful micro contrasts locally (?):

I also tried YCbCr instead, and it was similar.

I also tried CLAHE (Contrast Limited Adaptive Histogram Equalization) with various

tileGridSizefrom1to1000:img3 = cv2.imread(f) img_transf = cv2.cvtColor(img3, cv2.COLOR_BGR2HSV) clahe = cv2.createCLAHE(tileGridSize=(100,100)) img_transf[:,:,2] = clahe.apply(img_transf[:,:,2]) img4 = cv2.cvtColor(img_transf, cv2.COLOR_HSV2BGR) cv2.imwrite('test.jpg', img4)but the result was equally awful too.

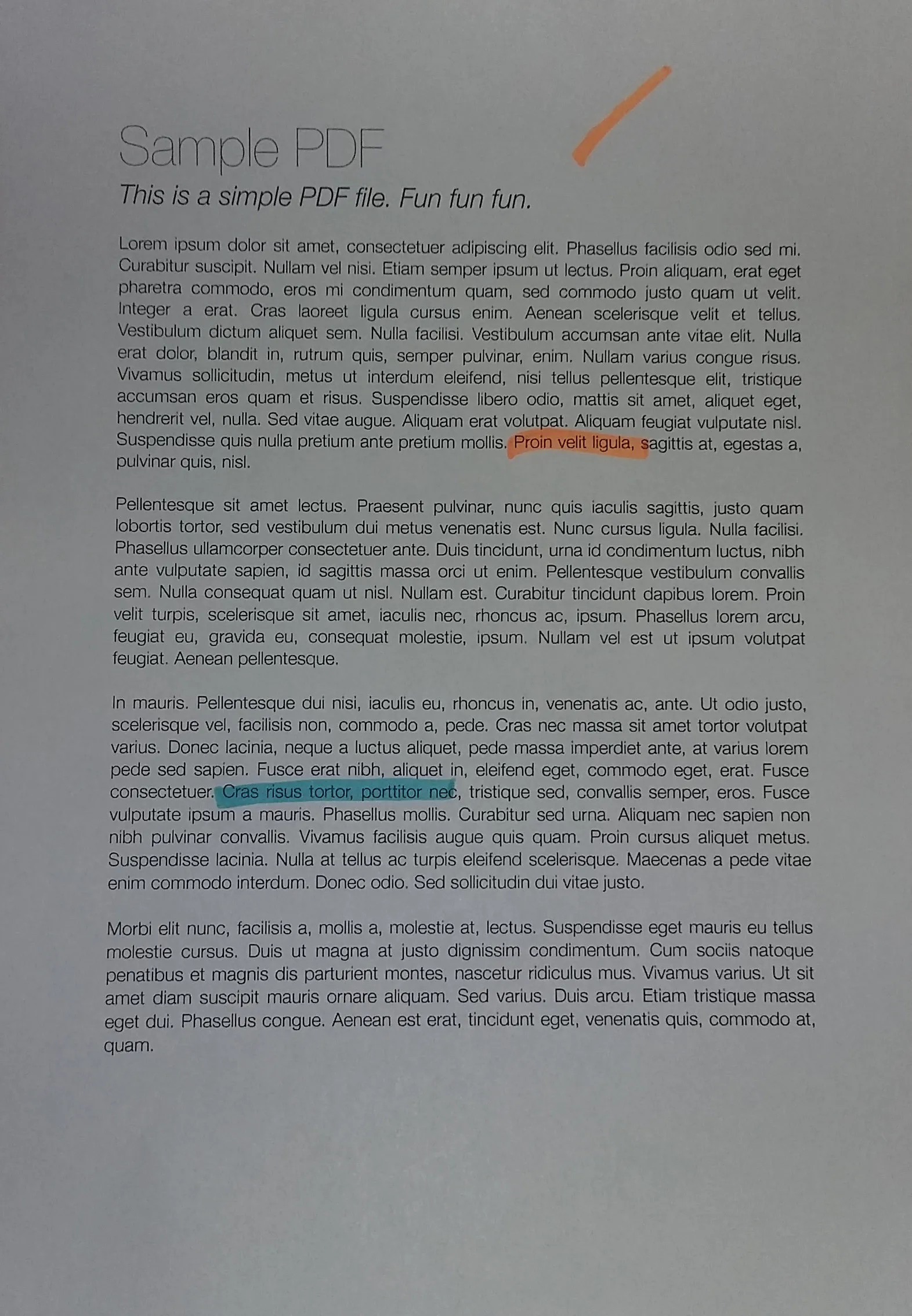

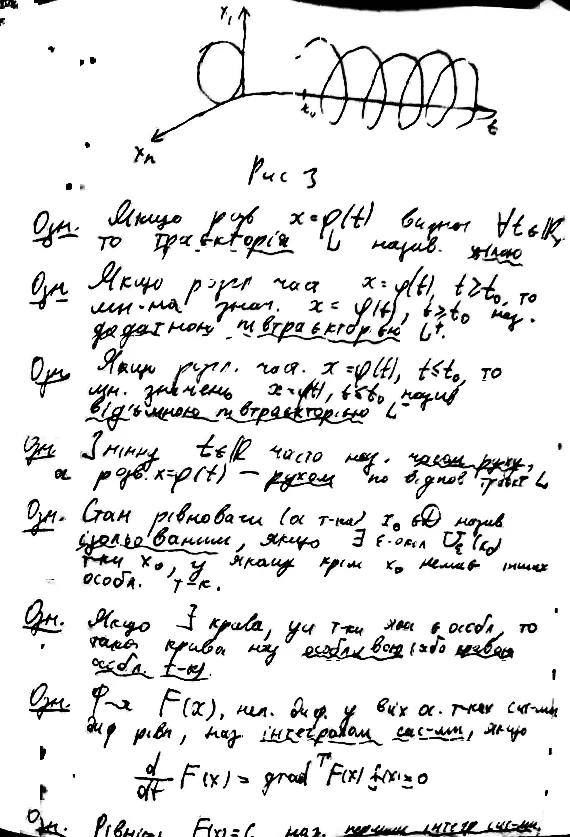

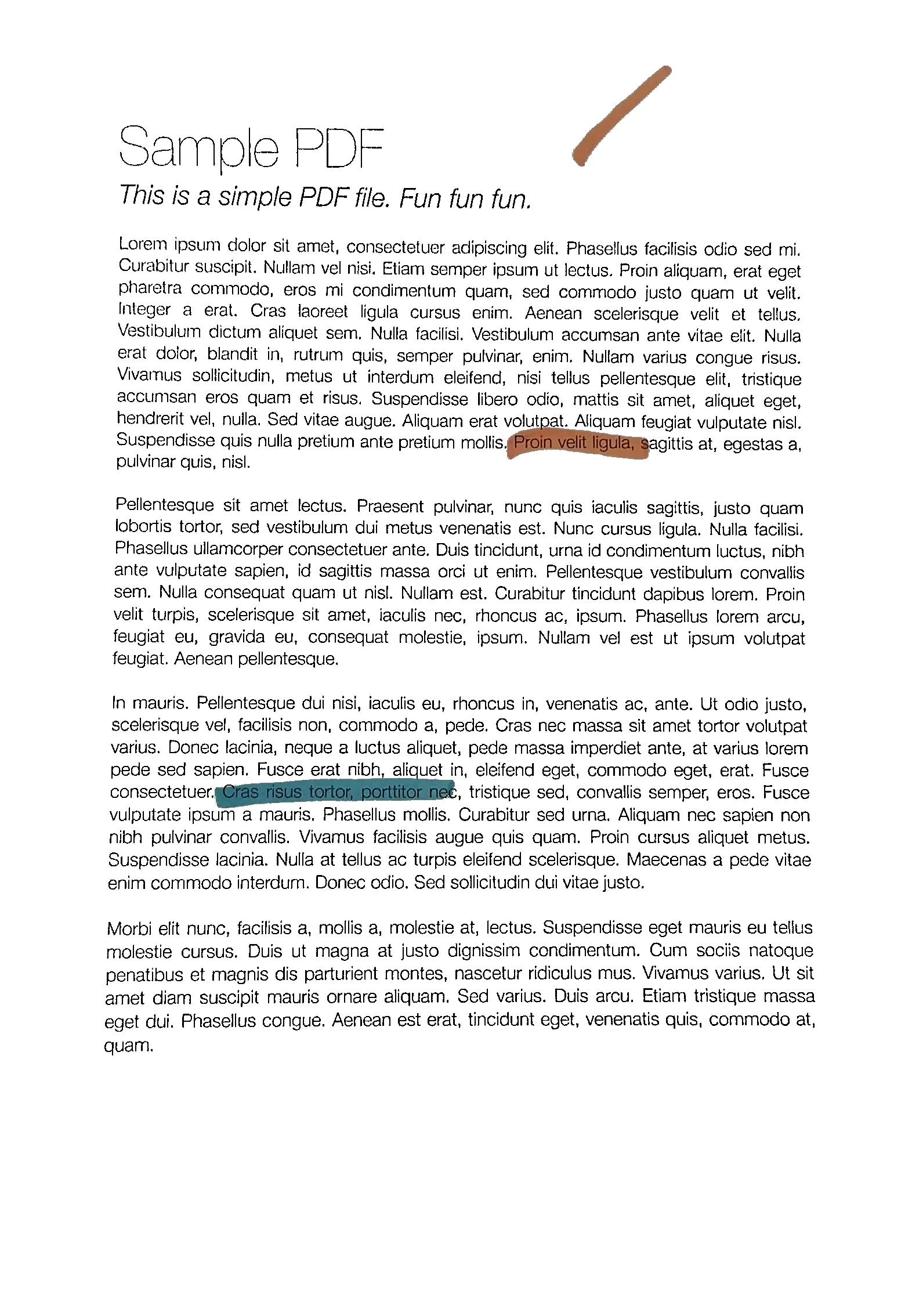

Doing this CLAHE method with LAB color space, as suggested in the question How to apply CLAHE on RGB color images:

import cv2, numpy as np bgr = cv2.imread('_example.jpg') lab = cv2.cvtColor(bgr, cv2.COLOR_BGR2LAB) lab_planes = cv2.split(lab) clahe = cv2.createCLAHE(clipLimit=2.0,tileGridSize=(100,100)) lab_planes[0] = clahe.apply(lab_planes[0]) lab = cv2.merge(lab_planes) bgr = cv2.cvtColor(lab, cv2.COLOR_LAB2BGR) cv2.imwrite('_example111.jpg', bgr)gave bad result too. Output image:

Do an adaptive thresholding or histogram equalization separately on each channel (R, G, B) is not an option since it would mess with the color balance, as explained here.

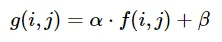

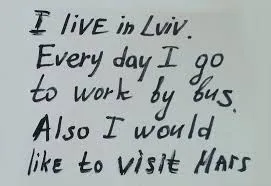

"Contrast strechting" method from

scikit-image's tutorial on Histogram Equalization:the image is rescaled to include all intensities that fall within the 2nd and 98th percentiles

is a little bit better, but still far from the desired result (see image on top of this question).

TL;DR:如何使用OpenCV/Python对彩色纸张照片进行自动亮度/对比度优化?可以使用什么样的阈值处理/直方图均衡化/其他技术?