我正在尝试提高我的Spark Scala技能,但是我有一个问题没有办法解决,请给予建议!

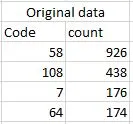

我有如下所示的原始数据:

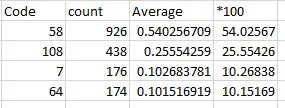

我想计算每个count列结果的百分比。例如,最后一个error值为64,那么所有列值中的64占多少百分比。请注意,我使用sqlContext将原始数据读取为Dataframes:

这是我的代码:

val df1 = df.groupBy(" Code")

.agg(sum("count").alias("sum"), mean("count")

.multiply(100)

.cast("integer").alias("percentage"))

我希望能够得到类似这样的结果:

提前感谢!