我们需要处理各种目录中大约500GB的图像。每个图像大小约为4MB,我们有一个Python脚本可以逐个处理每个图像(读取元数据并将其存储在数据库中)。每个目录的处理时间根据大小不同可能需要1-4小时。

我们使用GNU/Linux操作系统上的2.2GHz四核处理器和16GB的RAM。当前脚本只利用一个处理器。如何充分利用其他核心和RAM加快图像处理速度?启动多个Python进程来运行脚本是否能利用其他核心呢?

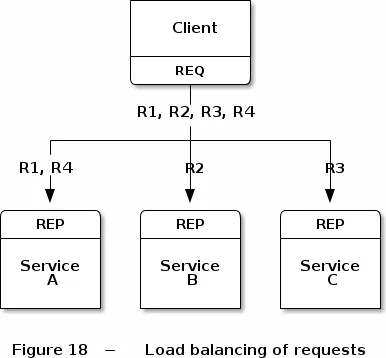

另一种选择是使用像Gearman或Beanstalk这样的工具将工作分配给其他机器。我已经查看了multiprocessing库,但不确定如何使用。