我正在Databricks集群上执行一个Spark作业。我通过Azure Data Factory管道触发作业,并在15分钟的时间间隔内执行,但在

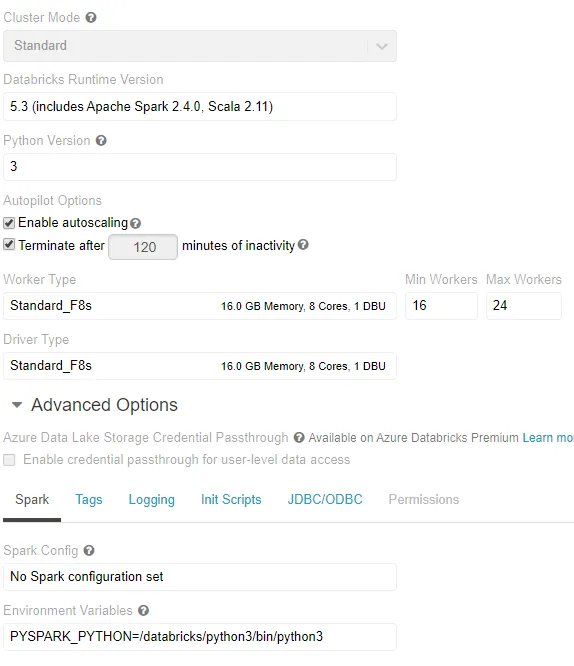

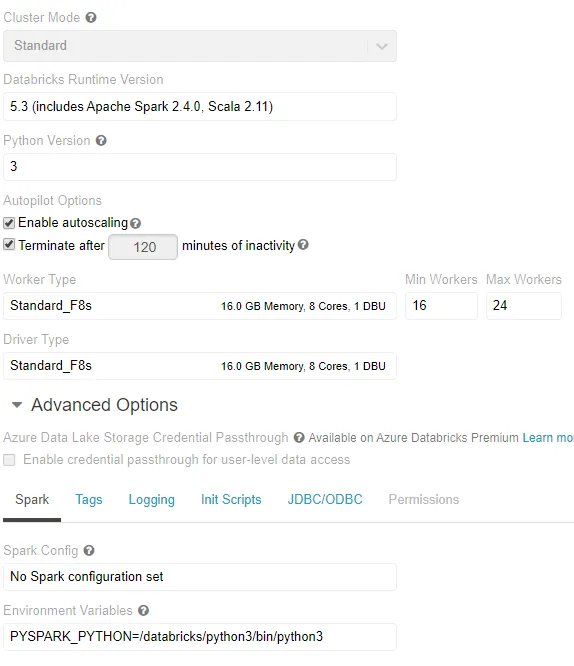

我的集群配置是: 那么我的问题是应该在服务器配置中做哪些更改。如果问题来自于我的代码,为什么大部分时间都能够成功执行。请给出建议并给我提供解决方案。

那么我的问题是应该在服务器配置中做哪些更改。如果问题来自于我的代码,为什么大部分时间都能够成功执行。请给出建议并给我提供解决方案。

成功执行三到四次后,作业失败并抛出异常"java.lang.OutOfMemoryError: GC overhead limit exceeded"。

虽然有许多关于上述问题的答案,但在大多数情况下,它们的作业都未运行,但在我的情况下,它在之前的一些作业成功执行后失败了。

我的数据大小只有不到20 MB。我的集群配置是:

那么我的问题是应该在服务器配置中做哪些更改。如果问题来自于我的代码,为什么大部分时间都能够成功执行。请给出建议并给我提供解决方案。

那么我的问题是应该在服务器配置中做哪些更改。如果问题来自于我的代码,为什么大部分时间都能够成功执行。请给出建议并给我提供解决方案。