我尝试使用Python的进程池多处理功能。

无论我如何设置块大小(在Windows 7和Ubuntu下 - 后者使用4个内核,见下文),并行线程的数量似乎保持不变。

from multiprocessing import Pool

from multiprocessing import cpu_count

import multiprocessing

import time

def f(x):

print("ready to sleep", x, multiprocessing.current_process())

time.sleep(20)

print("slept with:", x, multiprocessing.current_process())

if __name__ == '__main__':

processes = cpu_count()

print('-' * 20)

print('Utilizing %d cores' % processes)

print('-' * 20)

pool = Pool(processes)

myList = []

runner = 0

while runner < 40:

myList.append(runner)

runner += 1

print("len(myList):", len(myList))

# chunksize = int(len(myList) / processes)

# chunksize = processes

chunksize = 1

print("chunksize:", chunksize)

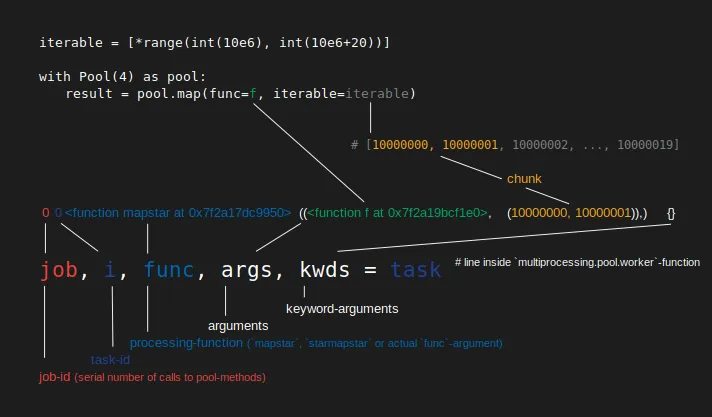

pool.map(f, myList, 1)

无论我使用

chunksize = int(len(myList) / processes),chunksize = processes还是1(如上面的例子),行为都是相同的。

可能自动将chunksize设置为核心数量吗?

chunksize = 1的示例:

--------------------

Utilizing 4 cores

--------------------

len(myList): 40

chunksize: 10

ready to sleep 0 <ForkProcess(ForkPoolWorker-1, started daemon)>

ready to sleep 1 <ForkProcess(ForkPoolWorker-2, started daemon)>

ready to sleep 2 <ForkProcess(ForkPoolWorker-3, started daemon)>

ready to sleep 3 <ForkProcess(ForkPoolWorker-4, started daemon)>

slept with: 0 <ForkProcess(ForkPoolWorker-1, started daemon)>

ready to sleep 4 <ForkProcess(ForkPoolWorker-1, started daemon)>

slept with: 1 <ForkProcess(ForkPoolWorker-2, started daemon)>

ready to sleep 5 <ForkProcess(ForkPoolWorker-2, started daemon)>

slept with: 2 <ForkProcess(ForkPoolWorker-3, started daemon)>

ready to sleep 6 <ForkProcess(ForkPoolWorker-3, started daemon)>

slept with: 3 <ForkProcess(ForkPoolWorker-4, started daemon)>

ready to sleep 7 <ForkProcess(ForkPoolWorker-4, started daemon)>

slept with: 4 <ForkProcess(ForkPoolWorker-1, started daemon)>

ready to sleep 8 <ForkProcess(ForkPoolWorker-1, started daemon)>

slept with: 5 <ForkProcess(ForkPoolWorker-2, started daemon)>

ready to sleep 9 <ForkProcess(ForkPoolWorker-2, started daemon)>

slept with: 6 <ForkProcess(ForkPoolWorker-3, started daemon)>

ready to sleep 10 <ForkProcess(ForkPoolWorker-3, started daemon)>

slept with: 7 <ForkProcess(ForkPoolWorker-4, started daemon)>

ready to sleep 11 <ForkProcess(ForkPoolWorker-4, started daemon)>

slept with: 8 <ForkProcess(ForkPoolWorker-1, started daemon)>