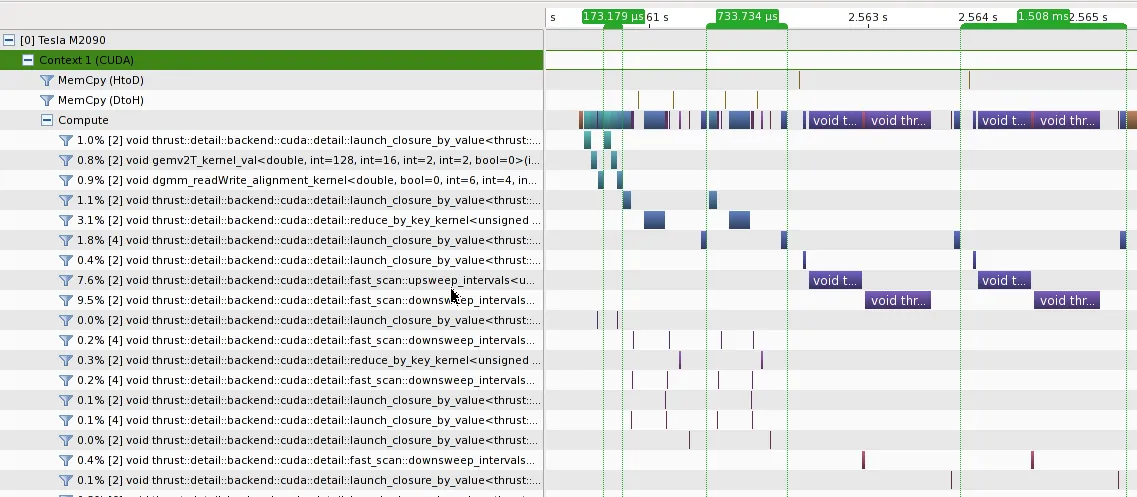

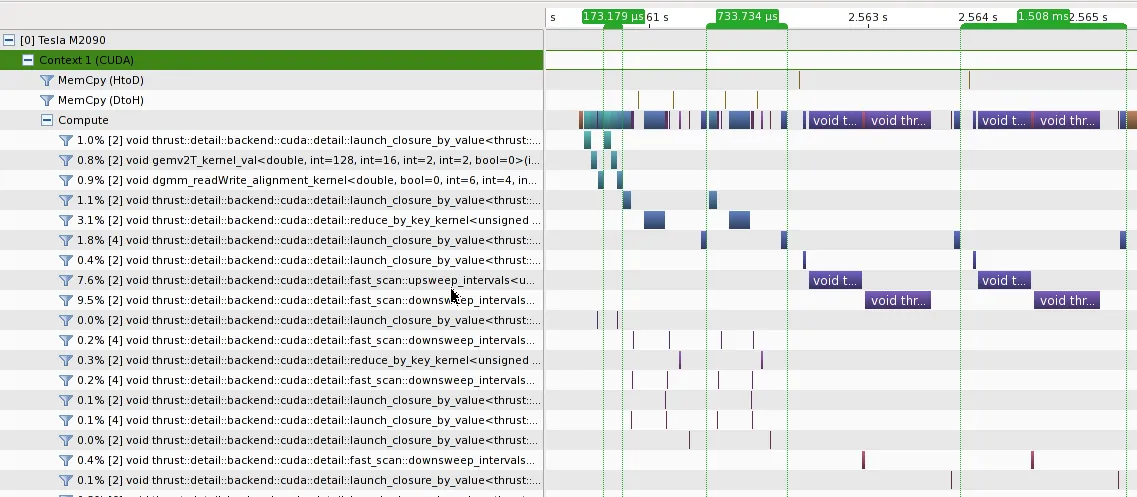

我使用CUDA 5.0在M2090上比较了3种方法的性能。

- [173.179 us] 在问题中展示的cublas实现

- [733.734 us] 使用

thrust::reduce_by_key的纯Thrust实现,来自@talonmies

- [1.508 ms] 使用

thrust::inclusive_scan_by_key的纯Thrust实现

可以看出:

- 在这种情况下,cublas具有最高的性能;

- 无论是

thrust::reduce_by_key还是thrust::inclusive_scan_by_key都会启动多个内核,从而导致额外的开销;

thrust::inclusive_scan_by_key相对于thrust::reduce_by_key会向DRAM写入更多的数据,这可能是内核时间较长的原因之一;- cublas和thrust方法之间的主要性能差异在于矩阵列求和。thrust较慢可能是因为

thrust::reduce_by_key被设计用于对长度不同的段进行归约,但cublas_gemv()只能应用于固定长度的段(行/列)。

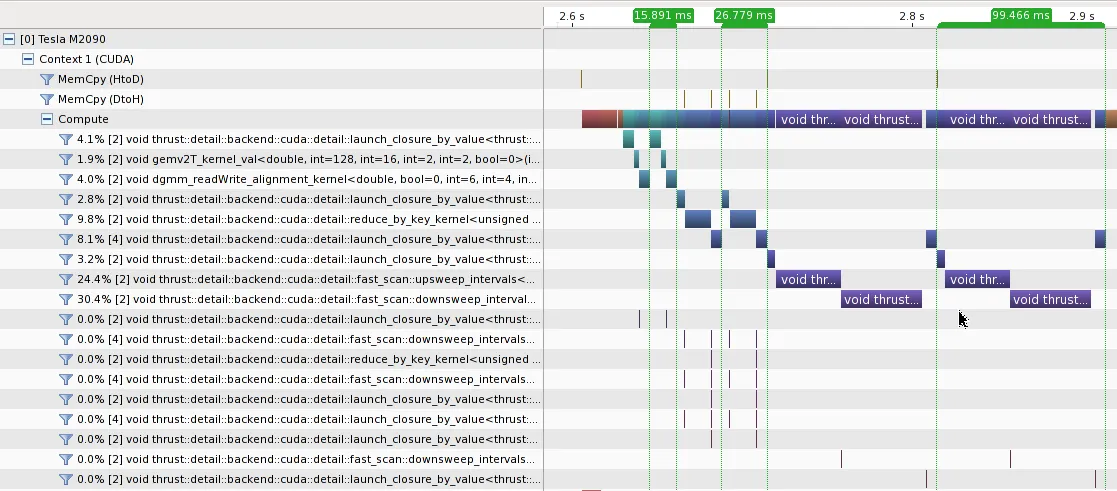

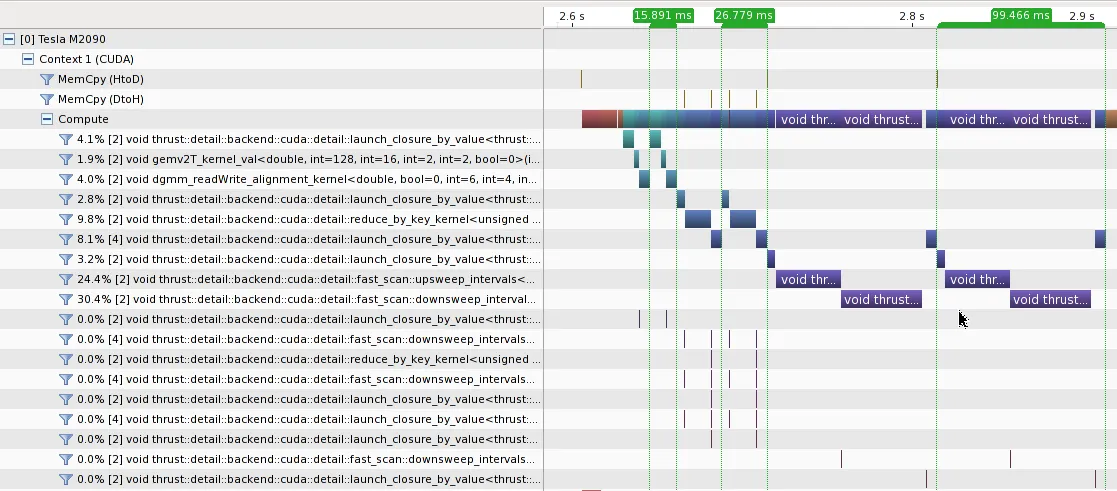

当矩阵A足够大以忽略内核启动开销时,cublas方法仍然表现最佳。在A_{20,000 x 2,000}上的分析结果如下所示。

将第一个

for_each操作与

cublasSgemv调用合并,如@talonmies所示,可能进一步提高性能,但我认为应使用手写内核而不是

thrust::reduce_by_key。

以下是3种方法的代码。

#include <cuda.h>

#include <curand.h>

#include <cublas_v2.h>

#include <thrust/device_vector.h>

#include <thrust/device_ptr.h>

#include <thrust/transform.h>

#include <thrust/reduce.h>

#include <thrust/scan.h>

#include <thrust/iterator/counting_iterator.h>

#include <thrust/iterator/transform_iterator.h>

#include <thrust/iterator/discard_iterator.h>

#include <thrust/iterator/permutation_iterator.h>

#include <math.h>

struct Exp: public thrust::unary_function<double, double>

{

__host__ __device__ double operator()(double x)

{

return exp(x);

}

};

struct Inv: public thrust::unary_function<double, double>

{

__host__ __device__ double operator()(double x)

{

return (double) 1.0 / x;

}

};

template<typename T>

struct MulC: public thrust::unary_function<T, T>

{

T C;

__host__ __device__ MulC(T c) :

C(c)

{

}

__host__ __device__ T operator()(T x)

{

return x * C;

}

};

template<typename T>

struct line2col: public thrust::unary_function<T, T>

{

T C;

__host__ __device__ line2col(T C) :

C(C)

{

}

__host__ __device__ T operator()(T i)

{

return i / C;

}

};

int main()

{

cudaDeviceSetCacheConfig(cudaFuncCachePreferShared);

cublasHandle_t hd;

curandGenerator_t rng;

cublasCreate(&hd);

curandCreateGenerator(&rng, CURAND_RNG_PSEUDO_DEFAULT);

const size_t m = 2000, n = 200;

const double c1 = 1.0;

const double c0 = 0.0;

thrust::device_vector<double> A(m * n);

thrust::device_vector<double> B(m * n);

thrust::device_vector<double> C(m * n);

thrust::device_vector<double> sum1(1 * n);

thrust::device_vector<double> sum2(1 * n);

thrust::device_vector<double> one(m * n, 1);

double* pA = thrust::raw_pointer_cast(&A[0]);

double* pB = thrust::raw_pointer_cast(&B[0]);

double* pSum1 = thrust::raw_pointer_cast(&sum1[0]);

double* pSum2 = thrust::raw_pointer_cast(&sum2[0]);

double* pOne = thrust::raw_pointer_cast(&one[0]);

curandGenerateUniformDouble(rng, pA, A.size());

const int count = 2;

for (int i = 0; i < count; i++)

{

thrust::transform(A.begin(), A.end(), B.begin(), Exp());

cublasDgemv(hd, CUBLAS_OP_T, m, n, &c1, pB, m, pOne, 1, &c0, pSum1, 1);

thrust::transform(sum1.begin(), sum1.end(), sum1.begin(), Inv());

cublasDdgmm(hd, CUBLAS_SIDE_RIGHT, m, n, pB, m, pSum2, 1, pB, m);

}

for (int i = 0; i < count; i++)

{

thrust::reduce_by_key(

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m)),

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m)) + A.size(),

thrust::make_transform_iterator(A.begin(), Exp()),

thrust::make_discard_iterator(),

sum2.begin());

thrust::transform(

A.begin(), A.end(),

thrust::make_permutation_iterator(

sum2.begin(),

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m))),

C.begin(),

thrust::divides<double>());

}

for (int i = 0; i < count; i++)

{

thrust::inclusive_scan_by_key(

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m)),

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m)) + A.size(),

thrust::make_transform_iterator(A.begin(), Exp()),

C.begin());

thrust::copy(

thrust::make_permutation_iterator(

C.begin() + m - 1,

thrust::make_transform_iterator(thrust::make_counting_iterator(0), MulC<int>(m))),

thrust::make_permutation_iterator(

C.begin() + m - 1,

thrust::make_transform_iterator(thrust::make_counting_iterator(0), MulC<int>(m))) + n,

sum2.begin());

thrust::transform(

A.begin(), A.end(),

thrust::make_permutation_iterator(

sum2.begin(),

thrust::make_transform_iterator(thrust::make_counting_iterator(0), line2col<int>(m))),

C.begin(),

thrust::divides<double>());

}

curandDestroyGenerator(rng);

cublasDestroy(hd);

return 0;

}