我可以通过例如

在哪里可以找到这些信息?换句话说,我如何查找分配给作业n的GPU是哪些?

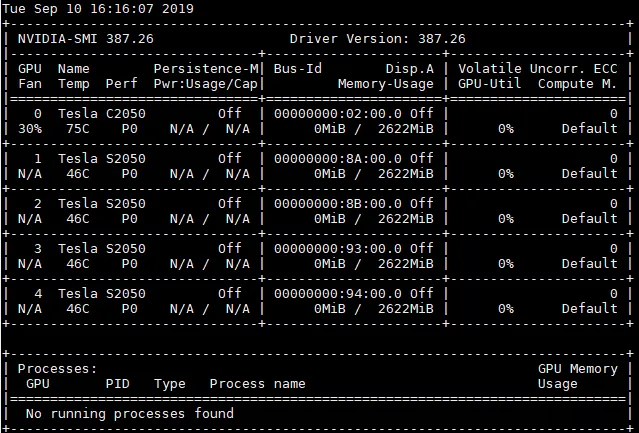

srun --gpus=2在slurm上运行作业,并设置CUDA_VISIBLE_DEVICES为分配的GPU。然而,我不知道查看SLURM分配给特定作业的GPU的方法。如果我运行scontrol show job,它会显示类似于TresPerJob=gpu:2的内容,但它并不包含实际分配的GPU信息。在哪里可以找到这些信息?换句话说,我如何查找分配给作业n的GPU是哪些?