我是数据科学领域的新手,我知道如何使用sklearn库和如何自定义RBF核函数,但我想为了学习目的从头开始实现SVM-RBF核,以及如何手动实现拟合和预测而不使用sklearn库。

有没有好的资源可以帮助我?我需要学习什么技能才能实现这个?你推荐哪些对于初学者来说易于理解机器学习主要概念的简单易懂的书籍作为起点呢?

非常感谢。

我是数据科学领域的新手,我知道如何使用sklearn库和如何自定义RBF核函数,但我想为了学习目的从头开始实现SVM-RBF核,以及如何手动实现拟合和预测而不使用sklearn库。

有没有好的资源可以帮助我?我需要学习什么技能才能实现这个?你推荐哪些对于初学者来说易于理解机器学习主要概念的简单易懂的书籍作为起点呢?

非常感谢。

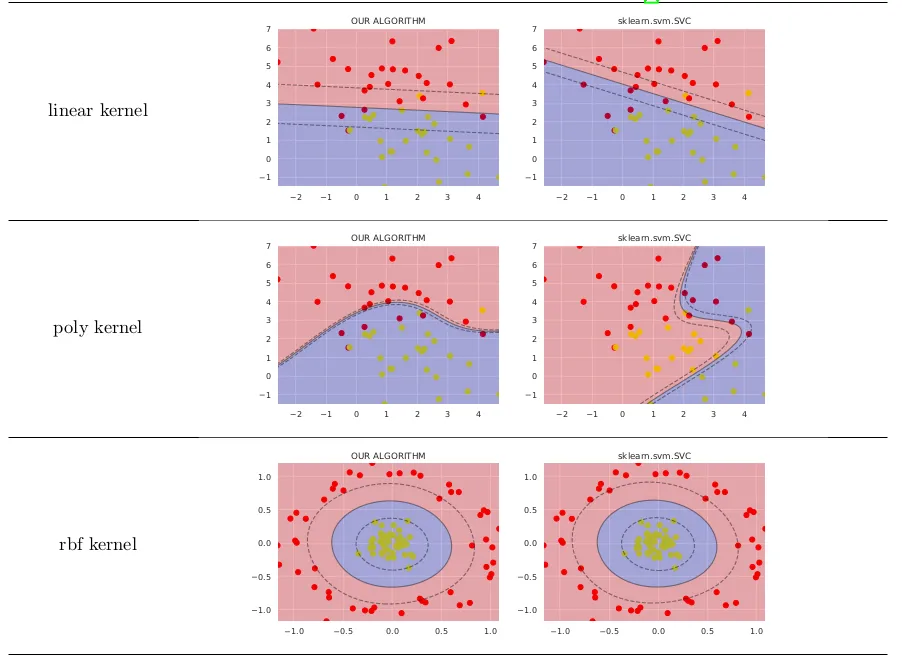

class SVM:

def __init__(self, kernel='linear', C=10000.0, max_iter=100000, degree=3, gamma=1):

self.kernel = {'poly':lambda x,y: np.dot(x, y.T)**degree,

'rbf':lambda x,y:np.exp(-gamma*np.sum((y-x[:,np.newaxis])**2,axis=-1)),

'linear':lambda x,y: np.dot(x, y.T)}[kernel]

self.C = C

self.max_iter = max_iter

def restrict_to_square(self, t, v0, u):

t = (np.clip(v0 + t*u, 0, self.C) - v0)[1]/u[1]

return (np.clip(v0 + t*u, 0, self.C) - v0)[0]/u[0]

def fit(self, X, y):

self.X = X.copy()

self.y = y * 2 - 1

self.lambdas = np.zeros_like(self.y, dtype=float)

self.K = self.kernel(self.X, self.X) * self.y[:,np.newaxis] * self.y

for _ in range(self.max_iter):

for idxM in range(len(self.lambdas)):

idxL = np.random.randint(0, len(self.lambdas))

Q = self.K[[[idxM, idxM], [idxL, idxL]], [[idxM, idxL], [idxM, idxL]]]

v0 = self.lambdas[[idxM, idxL]]

k0 = 1 - np.sum(self.lambdas * self.K[[idxM, idxL]], axis=1)

u = np.array([-self.y[idxL], self.y[idxM]])

t_max = np.dot(k0, u) / (np.dot(np.dot(Q, u), u) + 1E-15)

self.lambdas[[idxM, idxL]] = v0 + u * self.restrict_to_square(t_max, v0, u)

idx, = np.nonzero(self.lambdas > 1E-15)

self.b = np.sum((1.0-np.sum(self.K[idx]*self.lambdas, axis=1))*self.y[idx])/len(idx)

def decision_function(self, X):

return np.sum(self.kernel(X, self.X) * self.y * self.lambdas, axis=1) + self.b

。

。