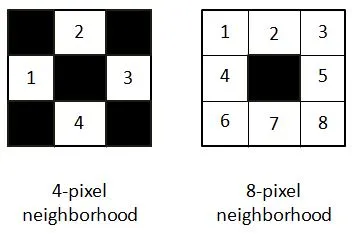

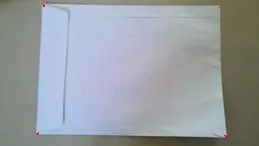

我正在尝试在一张图片中找到四个角落,不需要轮廓,只需要4个角落。我将使用这4个角落来改变透视。

我正在使用Opencv,但是我需要知道如何找到这些角落的步骤和要使用的函数。

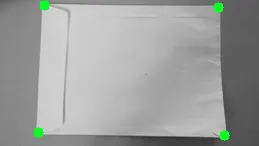

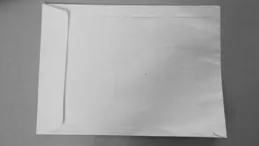

我的图片将是这样的:(没有红色点,我会在之后涂上这些点)

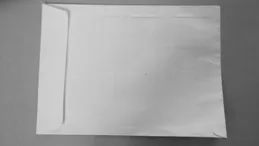

编辑:

按照建议的步骤,我写下了代码:(注意:我并没有使用纯OpenCV,而是使用javaCV,但是逻辑相同)。

// Load two images and allocate other structures (I´m using other image)

IplImage colored = cvLoadImage(

"res/scanteste.jpg",

CV_LOAD_IMAGE_UNCHANGED);

IplImage gray = cvCreateImage(cvGetSize(colored), IPL_DEPTH_8U, 1);

IplImage smooth = cvCreateImage(cvGetSize(colored), IPL_DEPTH_8U, 1);

//Step 1 - Convert from RGB to grayscale (cvCvtColor)

cvCvtColor(colored, gray, CV_RGB2GRAY);

//2 Smooth (cvSmooth)

cvSmooth( gray, smooth, CV_BLUR, 9, 9, 2, 2);

//3 - cvThreshold - What values?

cvThreshold(gray,gray, 155, 255, CV_THRESH_BINARY);

//4 - Detect edges (cvCanny) -What values?

int N = 7;

int aperature_size = N;

double lowThresh = 20;

double highThresh = 40;

cvCanny( gray, gray, lowThresh*N*N, highThresh*N*N, aperature_size );

//5 - Find contours (cvFindContours)

int total = 0;

CvSeq contour2 = new CvSeq(null);

CvMemStorage storage2 = cvCreateMemStorage(0);

CvMemStorage storageHull = cvCreateMemStorage(0);

total = cvFindContours(gray, storage2, contour2, Loader.sizeof(CvContour.class), CV_RETR_CCOMP, CV_CHAIN_APPROX_NONE);

if(total > 1){

while (contour2 != null && !contour2.isNull()) {

if (contour2.elem_size() > 0) {

//6 - Approximate contours with linear features (cvApproxPoly)

CvSeq points = cvApproxPoly(contour2,Loader.sizeof(CvContour.class), storage2, CV_POLY_APPROX_DP,cvContourPerimeter(contour2)*0.005, 0);

cvDrawContours(gray, points,CvScalar.BLUE, CvScalar.BLUE, -1, 1, CV_AA);

}

contour2 = contour2.h_next();

}

}

我想找到图像的角点,但是我不知道如何使用诸如cvCornerHarris等函数来查找角点。