我试图将本地文件夹推送到GitHub上的远程仓库,但遇到了问题。

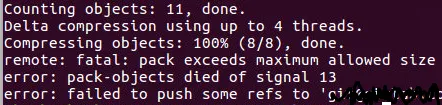

在推送到96%左右时出现以下情况...

Counting objects: 4145, done.

Delta compression using up to 2 threads.

Connection to github.com closed by remote host.

fatal: The remote end hung up unexpectedly

Compressing objects: 98% (3919/3969)

然后在最后2%完成之后,它显示了这个错误...

Compressing objects: 100% (3963/3963), done.

error: pack-objects died of signal 13

error: failed to push some refs to 'git@github.com:example/example.git'

不确定那是什么意思。