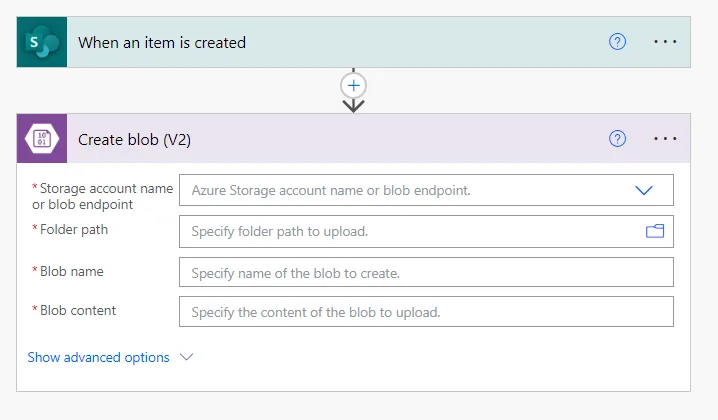

我有一些存储在SharePoint Online中的Excel文件。我希望将存储在SharePoint文件夹中的文件复制到Azure Blob存储中。

为了实现这一目标,我正在使用Azure Portal在Azure Data Factory中创建一个新的管道。使用Azure Data Factory管道,有哪些可能的方法可以将文件从SharePoint复制到Azure Blob存储?

我已查看了Azure Data Factory管道中所有链接服务类型,但没有找到任何适合连接到SharePoint的类型。