我正在使用实时摄像头输出来更新MTKView上的CIImage。我的主要问题是,尽管我遇到的所有设置都相同,但旧版iPhone比新版iPhone具有更好的CPU性能,出现了明显的性能差异。

这是一个冗长的帖子,但我决定包括这些细节,因为它们可能对这个问题的原因很重要。请让我知道我还可以添加什么。

下面是我的captureOutput函数,其中包含两个debug bools,我可以在运行时打开和关闭它们。我使用这个函数来试图确定我的问题的原因。

applyLiveFilter-bool是否使用CIFilter操作CIImage。 updateMetalView-bool是否更新MTKView的CIImage。

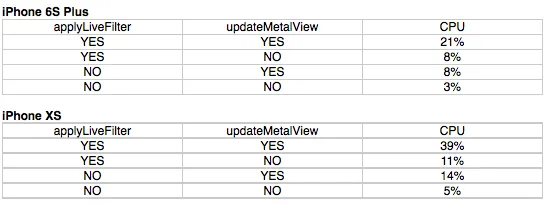

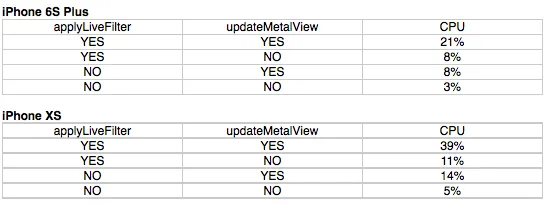

以下是两部手机在不同的布尔值组合下的结果图表: 即使没有使用Metal视图的CIIMage更新和未应用任何过滤器,iPhone XS的CPU比iPhone 6S Plus高2%,这并不是一个显著的开销,但这让我怀疑相机在捕捉图像时在设备之间存在某些差异。

即使没有使用Metal视图的CIIMage更新和未应用任何过滤器,iPhone XS的CPU比iPhone 6S Plus高2%,这并不是一个显著的开销,但这让我怀疑相机在捕捉图像时在设备之间存在某些差异。

我的AVCaptureSession预设在两部手机之间设置为相同 (AVCaptureSession.Preset.hd1280x720)。 从captureOutput创建的CIImage在两部手机之间大小(范围)相同。

是否有任何设置需要在这两个手机的AVCaptureDevice设置中手动设置,包括activeFormat属性,以使它们在设备之间相同?

我现在拥有的设置是:

视频和麦克风分别记录在两个不同的流中。由于我专注于直播摄像头输出的性能,因此麦克风和录制视频的详细信息被省略了。

更新 - 我在GitHub上有一个简化的测试项目,可以更轻松地测试我遇到的问题:https://github.com/PunchyBass/Live-Filter-test-project

这是一个冗长的帖子,但我决定包括这些细节,因为它们可能对这个问题的原因很重要。请让我知道我还可以添加什么。

下面是我的captureOutput函数,其中包含两个debug bools,我可以在运行时打开和关闭它们。我使用这个函数来试图确定我的问题的原因。

applyLiveFilter-bool是否使用CIFilter操作CIImage。 updateMetalView-bool是否更新MTKView的CIImage。

// live output from camera

func captureOutput(_ output: AVCaptureOutput, didOutput sampleBuffer: CMSampleBuffer, from connection: AVCaptureConnection){

/*

Create CIImage from camera.

Here I save a few percent of CPU by using a function

to convert a sampleBuffer to a Metal texture, but

whether I use this or the commented out code

(without captureOutputMTLOptions) does not have

significant impact.

*/

guard let texture:MTLTexture = convertToMTLTexture(sampleBuffer: sampleBuffer) else{

return

}

var cameraImage:CIImage = CIImage(mtlTexture: texture, options: captureOutputMTLOptions)!

var transform: CGAffineTransform = .identity

transform = transform.scaledBy(x: 1, y: -1)

transform = transform.translatedBy(x: 0, y: -cameraImage.extent.height)

cameraImage = cameraImage.transformed(by: transform)

/*

// old non-Metal way of getting the ciimage from the cvPixelBuffer

guard let pixelBuffer = CMSampleBufferGetImageBuffer(sampleBuffer) else

{

return

}

var cameraImage:CIImage = CIImage(cvPixelBuffer: pixelBuffer)

*/

var orientation = UIImage.Orientation.right

if(isFrontCamera){

orientation = UIImage.Orientation.leftMirrored

}

// apply filter to camera image

if debug_applyLiveFilter {

cameraImage = self.applyFilterAndReturnImage(ciImage: cameraImage, orientation: orientation, currentCameraRes:currentCameraRes!)

}

DispatchQueue.main.async(){

if debug_updateMetalView {

self.MTLCaptureView!.image = cameraImage

}

}

}

以下是两部手机在不同的布尔值组合下的结果图表:

即使没有使用Metal视图的CIIMage更新和未应用任何过滤器,iPhone XS的CPU比iPhone 6S Plus高2%,这并不是一个显著的开销,但这让我怀疑相机在捕捉图像时在设备之间存在某些差异。

即使没有使用Metal视图的CIIMage更新和未应用任何过滤器,iPhone XS的CPU比iPhone 6S Plus高2%,这并不是一个显著的开销,但这让我怀疑相机在捕捉图像时在设备之间存在某些差异。我的AVCaptureSession预设在两部手机之间设置为相同 (AVCaptureSession.Preset.hd1280x720)。 从captureOutput创建的CIImage在两部手机之间大小(范围)相同。

是否有任何设置需要在这两个手机的AVCaptureDevice设置中手动设置,包括activeFormat属性,以使它们在设备之间相同?

我现在拥有的设置是:

if let captureDevice = AVCaptureDevice.default(for:AVMediaType.video) {

do {

try captureDevice.lockForConfiguration()

captureDevice.isSubjectAreaChangeMonitoringEnabled = true

captureDevice.focusMode = AVCaptureDevice.FocusMode.continuousAutoFocus

captureDevice.exposureMode = AVCaptureDevice.ExposureMode.continuousAutoExposure

captureDevice.unlockForConfiguration()

} catch {

// Handle errors here

print("There was an error focusing the device's camera")

}

}

我的MTKView基于Simon Gladman编写的代码,为了提高性能并在使用苹果建议的核心动画将渲染缩放到屏幕宽度之前进行缩放而进行了一些编辑。

class MetalImageView: MTKView

{

let colorSpace = CGColorSpaceCreateDeviceRGB()

var textureCache: CVMetalTextureCache?

var sourceTexture: MTLTexture!

lazy var commandQueue: MTLCommandQueue =

{

[unowned self] in

return self.device!.makeCommandQueue()

}()!

lazy var ciContext: CIContext =

{

[unowned self] in

return CIContext(mtlDevice: self.device!)

}()

override init(frame frameRect: CGRect, device: MTLDevice?)

{

super.init(frame: frameRect,

device: device ?? MTLCreateSystemDefaultDevice())

if super.device == nil

{

fatalError("Device doesn't support Metal")

}

CVMetalTextureCacheCreate(kCFAllocatorDefault, nil, self.device!, nil, &textureCache)

framebufferOnly = false

enableSetNeedsDisplay = true

isPaused = true

preferredFramesPerSecond = 30

}

required init(coder: NSCoder)

{

fatalError("init(coder:) has not been implemented")

}

// The image to display

var image: CIImage?

{

didSet

{

setNeedsDisplay()

}

}

override func draw(_ rect: CGRect)

{

guard var

image = image,

let targetTexture:MTLTexture = currentDrawable?.texture else

{

return

}

let commandBuffer = commandQueue.makeCommandBuffer()

let customDrawableSize:CGSize = drawableSize

let bounds = CGRect(origin: CGPoint.zero, size: customDrawableSize)

let originX = image.extent.origin.x

let originY = image.extent.origin.y

let scaleX = customDrawableSize.width / image.extent.width

let scaleY = customDrawableSize.height / image.extent.height

let scale = min(scaleX*IVScaleFactor, scaleY*IVScaleFactor)

image = image

.transformed(by: CGAffineTransform(translationX: -originX, y: -originY))

.transformed(by: CGAffineTransform(scaleX: scale, y: scale))

ciContext.render(image,

to: targetTexture,

commandBuffer: commandBuffer,

bounds: bounds,

colorSpace: colorSpace)

commandBuffer?.present(currentDrawable!)

commandBuffer?.commit()

}

}

下面是我的AVCaptureSession(captureSession)和AVCaptureVideoDataOutput(videoOutput)设置:

func setupCameraAndMic(){

let backCamera = AVCaptureDevice.default(for:AVMediaType.video)

var error: NSError?

var videoInput: AVCaptureDeviceInput!

do {

videoInput = try AVCaptureDeviceInput(device: backCamera!)

} catch let error1 as NSError {

error = error1

videoInput = nil

print(error!.localizedDescription)

}

if error == nil &&

captureSession!.canAddInput(videoInput) {

guard CVMetalTextureCacheCreate(kCFAllocatorDefault, nil, MetalDevice, nil, &textureCache) == kCVReturnSuccess else {

print("Error: could not create a texture cache")

return

}

captureSession!.addInput(videoInput)

setDeviceFrameRateForCurrentFilter(device:backCamera)

stillImageOutput = AVCapturePhotoOutput()

if captureSession!.canAddOutput(stillImageOutput!) {

captureSession!.addOutput(stillImageOutput!)

let q = DispatchQueue(label: "sample buffer delegate", qos: .default)

videoOutput.setSampleBufferDelegate(self, queue: q)

videoOutput.videoSettings = [

kCVPixelBufferPixelFormatTypeKey as AnyHashable as! String: NSNumber(value: kCVPixelFormatType_32BGRA),

kCVPixelBufferMetalCompatibilityKey as String: true

]

videoOutput.alwaysDiscardsLateVideoFrames = true

if captureSession!.canAddOutput(videoOutput){

captureSession!.addOutput(videoOutput)

}

captureSession!.startRunning()

}

}

setDefaultFocusAndExposure()

}

视频和麦克风分别记录在两个不同的流中。由于我专注于直播摄像头输出的性能,因此麦克风和录制视频的详细信息被省略了。

更新 - 我在GitHub上有一个简化的测试项目,可以更轻松地测试我遇到的问题:https://github.com/PunchyBass/Live-Filter-test-project