我正在运行一个程序,以测试在具有大量文件的文件夹中查找和迭代所有文件的速度。该过程中最慢的部分是创建100万多个文件。目前我使用的是相当幼稚的方法来创建这些文件:

Console.Write("Creating {0:N0} file(s) of size {1:N0} bytes... ",

options.FileCount, options.FileSize);

var createTimer = Stopwatch.StartNew();

var fileNames = new List<string>();

for (long i = 0; i < options.FileCount; i++)

{

var filename = Path.Combine(options.Directory.FullName,

CreateFilename(i, options.FileCount));

using (var file = new FileStream(filename, FileMode.CreateNew,

FileAccess.Write, FileShare.None, 4096,

FileOptions.WriteThrough))

{

// I have an option to write some data to files, but it's not being used.

// That's why there's a using here.

}

fileNames.Add(filename);

}

createTimer.Stop();

Console.WriteLine("Done.");

// Other code appears here.....

Console.WriteLine("Time to CreateFiles: {0:N3}sec ({1:N2} files/sec, 1 in {2:N4}ms)"

, createTimer.Elapsed.TotalSeconds

, (double)total / createTimer.Elapsed.TotalSeconds

, createTimer.Elapsed.TotalMilliseconds / (double)options.FileCount);

输出:

Creating 1,000,000 file(s) of size 0 bytes... Done.

Time to CreateFiles: 9,182.283sec (1,089.05 files/sec, 1 in 9.1823ms)

有什么比这更好的方法吗?我希望测试超过100万个数量级,但创建文件需要一整天的时间!我还没有尝试任何形式的并行处理,尝试优化任何文件系统选项或更改文件创建顺序。为了完整起见,这里是“CreateFilename()”的内容:

public static string CreateFilename(long i, long totalFiles)

{

if (totalFiles < 0)

throw new ArgumentOutOfRangeException("totalFiles",

totalFiles, "totalFiles must be positive");

// This tries to keep filenames to the 8.3 format as much as possible.

if (totalFiles < 99999999)

// No extension.

return String.Format("{0:00000000}", i);

else if (totalFiles >= 100000000 && totalFiles < 9999999999)

{

// Extend numbers into extension.

long rem = 0;

long div = Math.DivRem(i, 1000, out rem);

return String.Format("{0:00000000}", div) + "." +

String.Format("{0:000}", rem);

}

else

// Doesn't fit in 8.3, so just tostring the long.

return i.ToString();

}

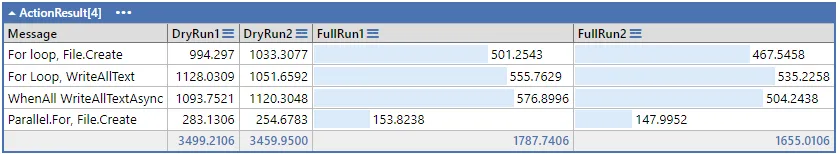

更新

按照StriplingWarrior的建议尝试使用Parallel.For()进行并行化。结果:约30个线程在我的磁盘上疯狂运转,导致网络速度变慢!

var fileNames = new ConcurrentBag<string>();

var opts = new ParallelOptions();

opts.MaxDegreeOfParallelism = 1; // 1 thread turns out to be fastest.

Parallel.For(0L, options.FileCount, opts,

() => new { Files = new List<string>() },

(i, parState, state) =>

{

var filename = Path.Combine(options.Directory.FullName,

CreateFilename(i, options.FileCount));

using (var file = new FileStream(filename, FileMode.CreateNew

, FileAccess.Write, FileShare.None

, 4096, FileOptions.WriteThrough))

{

}

fileNames.Add(filename);

return state;

},

state =>

{

foreach (var f in state.Files)

{

fileNames.Add(f);

}

});

createTimer.Stop();

Console.WriteLine("Done.");

发现在

FileStream中更改FileOptions可以提高性能约50%。看来我关闭了任何写缓存。new FileStream(filename, FileMode.CreateNew,

FileAccess.Write, FileShare.None,

4096, FileOptions.None)

结果:

Creating 10,000 file(s) of size 0 bytes... Done.

Time to CreateFiles: 12.390sec (8,071.05 files/sec, 1 in 1.2390ms)

欢迎提出其他想法。