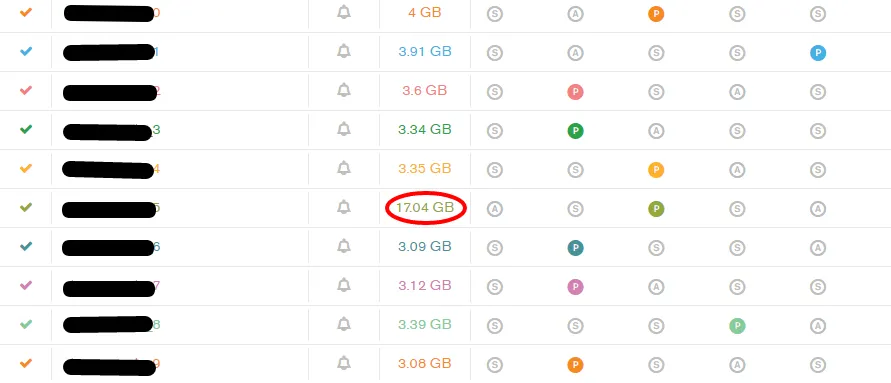

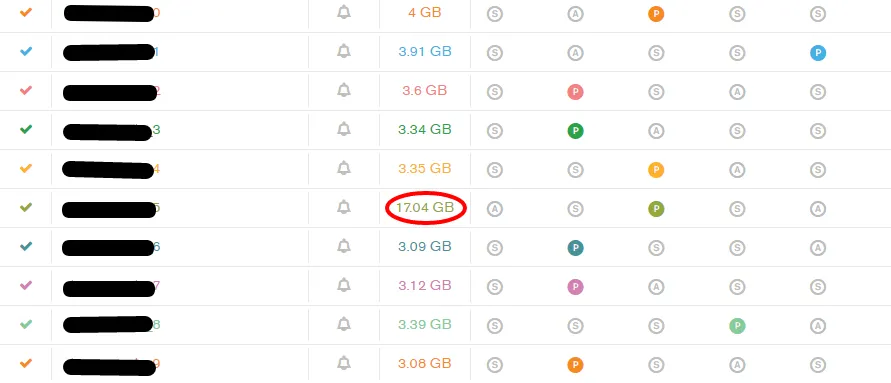

我为我的应用程序设置了一个分片集群,但不幸的是,其中一个分片的数据大小为17 GB,而其他分片的数据大小平均为3 GB。可能出了什么问题?

< p >  < p >

< p >

请建议我采取纠正措施来解决不平衡分片问题。

< p >

< p >sh.status()给我提供了大量输出。在这里分享:https://www.dropbox.com/s/qqsucbm6q9egbhf/shard.txt?dl=0

< p >我的糟糕的集合分片分布详细信息如下。

mongos> db.MyCollection_1_100000.getShardDistribution()

Shard shard_0 at shard_0/mongo-11.2816.mongodbdns.com:270

00,mongo-12.2816.mongodbdns.com:27000,mongo-13.2816. mongodbdns.com:27000,mongo-3.2816.mongodbdns.com:27003

data : 143.86MiB docs : 281828 chunks : 4

estimated data per chunk : 35.96MiB

estimated docs per chunk : 70457

Shard shard_1 at shard_1/mongo-10.2816.mongodbdns.com:270 00,mongo-11.2816.mongodbdns.com:27002,mongo-19.2816. mongodbdns.com:27001,mongo-9.2816.mongodbdns.com:27005

data : 107.66MiB docs : 211180 chunks : 3

estimated data per chunk : 35.88MiB

estimated docs per chunk : 70393

Shard shard_2 at shard_2/mongo-14.2816.mongodbdns.com:270 00,mongo-3.2816.mongodbdns.com:27000,mongo-4.2816.mo ngodbdns.com:27000,mongo-6.2816.mongodbdns.com:27002

data : 107.55MiB docs : 210916 chunks : 3

estimated data per chunk : 35.85MiB

estimated docs per chunk : 70305

Shard shard_3 at shard_3/mongo-14.2816.mongodbdns.com:270 04,mongo-18.2816.mongodbdns.com:27002,mongo-6.2816.m ongodbdns.com:27000,mongo-8.2816.mongodbdns.com:27000

data : 107.99MiB docs : 211506 chunks : 3

estimated data per chunk : 35.99MiB

estimated docs per chunk : 70502

Shard shard_4 at shard_4/mongo-12.2816.mongodbdns.com:270 01,mongo-13.2816.mongodbdns.com:27001,mongo-17.2816. mongodbdns.com:27002,mongo-6.2816.mongodbdns.com:27003

data : 107.92MiB docs : 211440 chunks : 3

estimated data per chunk : 35.97MiB

estimated docs per chunk : 70480

Shard shard_5 at shard_5/mongo-17.2816.mongodbdns.com:270 01,mongo-18.2816.mongodbdns.com:27001,mongo-19.2816. mongodbdns.com:27000

data : 728.64MiB docs : 1423913 chunks : 4

estimated data per chunk : 182.16MiB

estimated docs per chunk : 355978

Shard shard_6 at shard_6/mongo-10.2816.mongodbdns.com:270 01,mongo-14.2816.mongodbdns.com:27005,mongo-3.2816.m ongodbdns.com:27001,mongo-8.2816.mongodbdns.com:27003

data : 107.52MiB docs : 211169 chunks : 3

estimated data per chunk : 35.84MiB

estimated docs per chunk : 70389

Shard shard_7 at shard_7/mongo-17.2816.mongodbdns.com:270 00,mongo-18.2816.mongodbdns.com:27000,mongo-19.2816. mongodbdns.com:27003,mongo-9.2816.mongodbdns.com:27003

data : 107.87MiB docs : 211499 chunks : 3

estimated data per chunk : 35.95MiB

estimated docs per chunk : 70499

Shard shard_8 at shard_8/mongo-19.2816.mongodbdns.com:270 02,mongo-4.2816.mongodbdns.com:27002,mongo-8.2816.mo ngodbdns.com:27001,mongo-9.2816.mongodbdns.com:27001

data : 107.83MiB docs : 211154 chunks : 3

estimated data per chunk : 35.94MiB

estimated docs per chunk : 70384

Shard shard_9 at shard_9/mongo-10.2816.mongodbdns.com:270 02,mongo-11.2816.mongodbdns.com:27003,mongo-12.2816. mongodbdns.com:27002,mongo-13.2816.mongodbdns.com:27002

data : 107.84MiB docs : 211483 chunks : 3

estimated data per chunk : 35.94MiB

estimated docs per chunk : 70494

Totals

data : 1.69GiB docs : 3396088 chunks : 32

Shard shard_0 contains 8.29% data, 8.29% docs in cluster, avg obj size on shard : 535B

Shard shard_1 contains 6.2% data, 6.21% docs in cluster, avg obj size on shard : 5 34B

Shard shard_2 contains 6.2% data, 6.21% docs in cluster, avg obj size on shard : 5 34B

Shard shard_3 contains 6.22% data, 6.22% docs in cluster, avg obj size on shard : 535B

Shard shard_4 contains 6.22% data, 6.22% docs in cluster, avg obj size on shard : 535B

Shard shard_5 contains 42% data, 41.92% docs in cluster, avg obj size on shard : 5 36B

Shard shard_6 contains 6.19% data, 6.21% docs in cluster, avg obj size on shard : 533B

Shard shard_7 contains 6.21% data, 6.22% docs in cluster, avg obj size on shard : 534B

Shard shard_8 contains 6.21% data, 6.21% docs in cluster, avg obj size on shard : 535B

Shard shard_9 contains 6.21% data, 6.22% docs in cluster, avg obj size on shard : 534B

我有150多个类似的集合,我已通过用户ID将数据分开。

e.g. MyCollection_1_100000

MyCollection_100001_200000

MyCollection_200001_300000

这里我将用户ID数据从1到100000分成了MyCollection_1_100000等其他集合。

所有150多个集合的分片键都是连续数字,但它们被哈希了。应用方式如下:

db.MyCollection_1_100000.ensureIndex({"column": "hashed"})

sh.shardCollection("dbName.MyCollection_1_100000", { "column": "hashed" })

请建议我采取纠正措施来解决不平衡分片问题。

sh.status()输出,包括键范围。请还为每个分片集合添加db.youShardedColl.getShardDistribution()的输出。即使输出很大:我们也需要它。 - Markus W Mahlbergsh.status()很大,你可以将其内容发布到像 Dropbox 这样的文件共享服务中,并链接。 - ggallodb中只有一个集合吗?另外,你能否发布db.collection.stats()的输出结果?谢谢。 - Héctor Valverde