我试图找出如何使用C#在SQL Server中提高临时表的插入性能。有些人说我应该使用SQLBulkCopy,但似乎它比简单构建SQL插入字符串要慢得多。下面是我使用SQLBulkCopy创建表的代码:

public void MakeTable(string tableName, List<string> ids, SqlConnection connection)

{

SqlCommand cmd = new SqlCommand("CREATE TABLE ##" + tableName + " (ID int)", connection);

cmd.ExecuteNonQuery();

DataTable localTempTable = new DataTable(tableName);

DataColumn id = new DataColumn();

id.DataType = System.Type.GetType("System.Int32");

id.ColumnName = "ID";

localTempTable.Columns.Add(id);

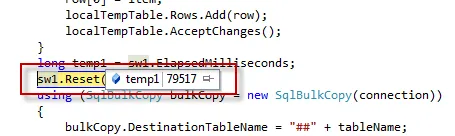

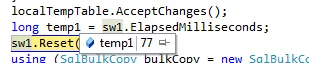

foreach (var item in ids)

{

DataRow row = localTempTable.NewRow();

row[0] = item;

localTempTable.Rows.Add(row);

localTempTable.AcceptChanges();

}

using (SqlBulkCopy bulkCopy = new SqlBulkCopy(connection))

{

bulkCopy.DestinationTableName = "##" + tableName;

bulkCopy.WriteToServer(localTempTable);

}

}

这样我的插入操作需要很长时间才能执行完。我用另一种方法来使我的插入操作更快:

我将插入操作的代码作为字符串创建,并在SQL临时表创建语句中连接它:

创建插入操作字符串:

public string prepareInserts(string tableName, List<string> ids)

{

List<string> inserts = new List<string>();

var total = ids.Select(p => p).Count();

var size = 1000;

var insert = 1;

var skip = size * (insert - 1);

var canPage = skip < total;

while (canPage)

{

inserts.Add(" insert into ##" + tableName + @" (ID) values " + String.Join(",", ids.Select(p => string.Format("({0})", p))

.Skip(skip)

.Take(size)

.ToArray()));

insert++;

skip = size * (insert - 1);

canPage = skip < total;

}

string joinedInserts = String.Join("\r\n", inserts.ToArray());

return joinedInserts;

}

在创建查询后,在SQL语句中使用它们:

inserts = prepareInserts(tableName, ids);

var query = @"IF EXISTS

(

SELECT *

FROM tempdb.dbo.sysobjects

WHERE ID = OBJECT_ID(N'tempdb..##" + tableName + @"')

)

BEGIN

DELETE FROM ##" + tableName + @"

END

ELSE

BEGIN

CREATE TABLE ##" + tableName + @"

(ID int)

END " + inserts;

var command = new SqlCommand(query, sqlConnection);

...

自从我看到有人在stack exchange(https://dba.stackexchange.com/questions/44217/fastest-way-to-insert-30-thousand-rows-in-sql-server/44222?noredirect=1#comment78137_44222)告诉我应该使用SQLBulkCopy,这样会更快,我相信我应该改善我的做法。所以如果有人能建议我如何改进我的SQLBulkCopy代码或告诉我是否有更好的插入语句可以提高我的应用程序性能,那将是非常棒的。