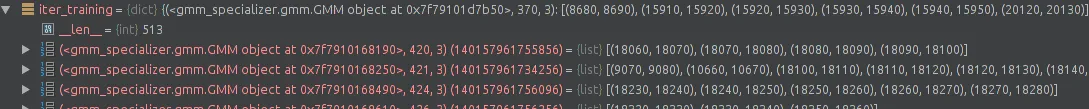

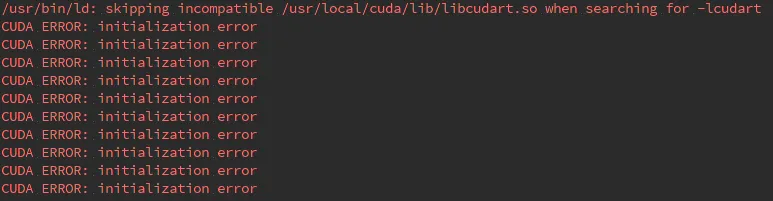

我使用CUDA来编写我的代码,但是它仍然运行缓慢。因此,我改用Python中的多进程(pool.map)并行运行。但是我遇到了CUDA ERROR: initialization error。

这是函数:

def step_M(self, iter_training):

gpe, e_tuple_list = iter_training

g = gpe[0]

p = gpe[1]

em_iters = gpe[2]

e_tuple_list = sorted(e_tuple_list, key=lambda tup: tup[0])

data = self.X[e_tuple_list[0][0]:e_tuple_list[0][1]]

cluster_indices = np.array(range(e_tuple_list[0][0], e_tuple_list[0][1], 1), dtype=np.int32)

for i in range(1, len(e_tuple_list)):

d = e_tuple_list[i]

cluster_indices = np.concatenate((cluster_indices, np.array(range(d[0], d[1], 1), dtype=np.int32)))

data = np.concatenate((data, self.X[d[0]:d[1]]))

g.train_on_subset(self.X, cluster_indices, max_em_iters=em_iters)

return g, cluster_indices, data

以下是代码调用:

pool = Pool()

iter_bic_list = pool.map(self.step_M, iter_training.items())