1个回答

3

TL;DR 不行。

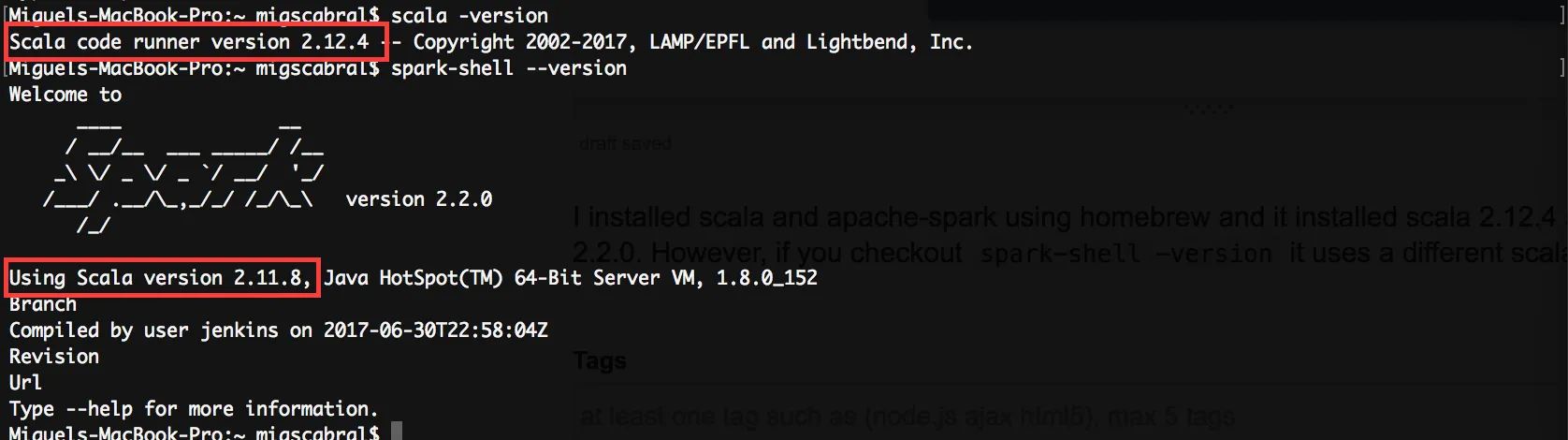

存在两个问题:

- Spark(实际上不仅限于Spark)将使用用来编译它的Scala版本。机器上安装的Scala编译版本完全不相关。

- 目前Spark还不支持Scala 2.12,因此重新编译也不是一个选项。

- user8822616

网页内容由stack overflow 提供, 点击上面的可以查看英文原文,

原文链接

原文链接

- 相关问题

- 7 不进入spark-shell,能否运行Spark Scala脚本?

- 3 使用Scala Apache Spark合并RDDs

- 4 Scala IDE和Apache Spark——在构建路径中发现了不同版本的Scala库

- 14 Scala/Spark版本兼容性

- 4 Spark 2.4.3使用哪个Scala版本? Scala版本号:2.11.12。

- 24 在Apache Spark(Scala)中使用reduceByKey

- 3 使用Apache Spark和Scala进行数据预处理

- 18 Homebrew安装了两个版本的icu4c

- 10 使用Scala和logback配置Apache Spark日志记录

- 5 使用Homebrew安装了Python3,但未使用更新版本