我想将一种类似日志的文件写回到Azure ADLS Gen1中。

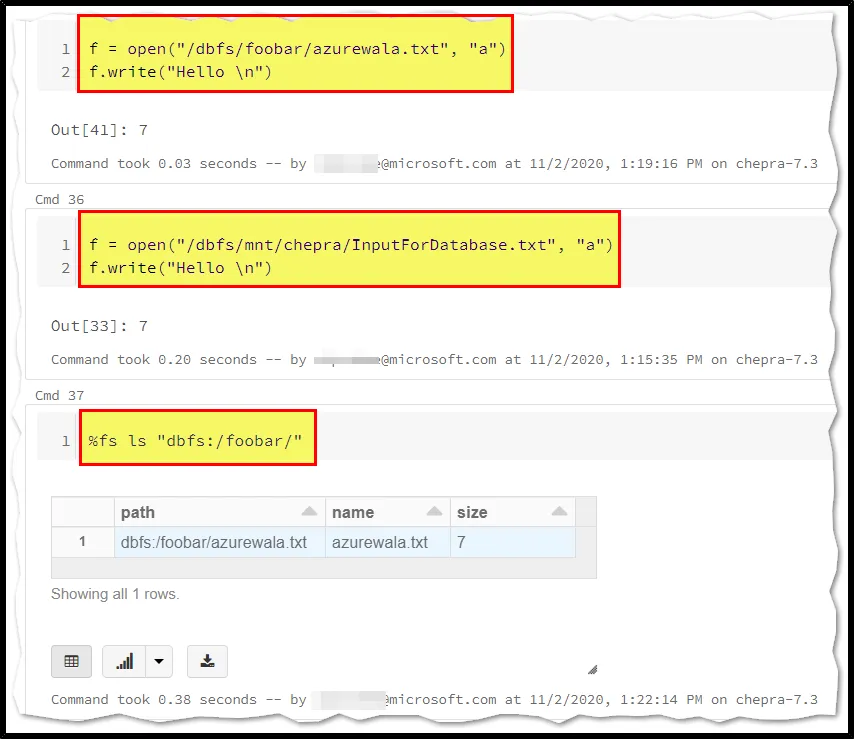

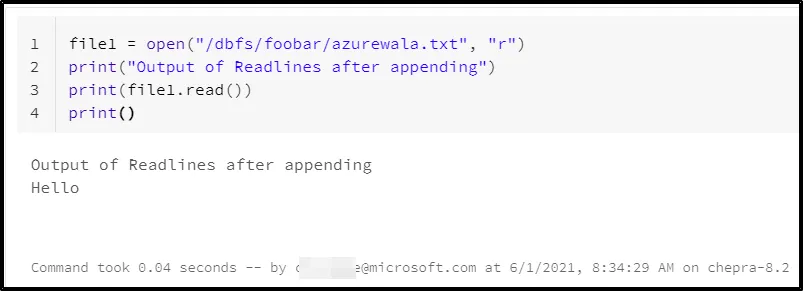

我可以使用以下方式进行写入(而不是追加):

dbutils.fs.put(filename,"random text")

但我无法使用以下方式追加它:

with open("/dbfs/mnt/filename.txt","a"):

f.write("random text")

它给我报错了。

1 with open("/dbfs/mnt/filename.txt", "a") as f:

----> 2 f.write("append values")

OSError: [Errno 95] Operation not supported

另外,我尝试使用 logger.basicconfig(logging.basicConfig(filename='dbfs:/mnt/filename.txt', filemode='w')

但是似乎没有写入路径。 有人可以帮忙吗?