我想使用 urllib.request.urlopen('someurl') 打开一个URL:

with urllib.request.urlopen('someurl') as url:

b = url.read()

我一直收到以下错误:

urllib.error.HTTPError: HTTP Error 403: Forbidden

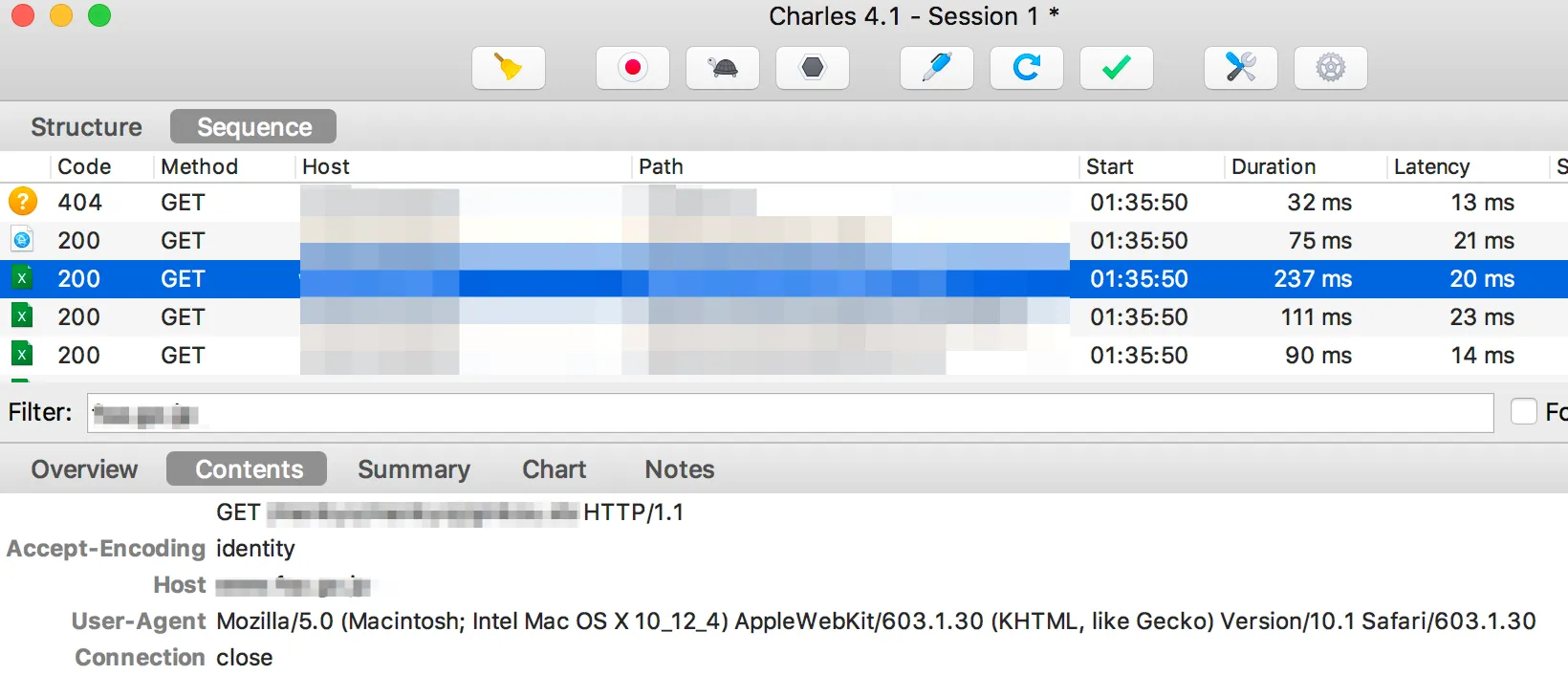

我理解这个错误是由于该网站不允许Python访问而导致的,以防止机器人浪费他们的网络资源,这是可以理解的。我搜索并发现需要更改urllib的用户代理才行。然而,我所找到的所有指南和解决方案都是针对urllib2的,而我正在使用Python 3,因此所有的解决方案都不起作用。

我应该如何用Python 3解决这个问题?