我使用nginx-uWSGI来托管我的Django应用程序。这是我的uWSGI配置:

I've django app host using nignx-uwsgi. Here is my uwsgi configuration:

[uwsgi]

master = true

socket = /var/uwsgi/uwsgi.sock

chmod-socket = 666

chdir = /home/ubuntu/test

wsgi-file = /home/ubuntu/test/test/wsgi.py

virtualenv = /home/ubuntu/virtual

vacuum = true

enable-threads = true

daemonize= /home/ubuntu/uwsgi.log

我在nginx日志中看到了错误信息:

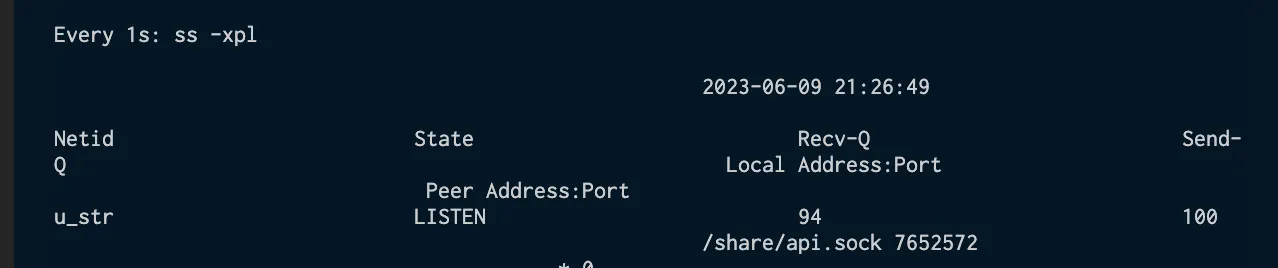

2017/06/16 04:25:42 [error] 26129#0: *1141328 connect() to unix:///var/uwsgi/uwsgi.sock failed (11: Resource temporarily unavailable) while connecting to upstream, client: xxx.xxx.xx, server:

同时网站显示502坏的网关。我必须重新启动uwsgi才能解决问题,但是错误发生的频率越来越高了。是否有什么方法可以解决这个问题?